Wenn Sie die Leistung Ihrer API verbessern möchten, ist der Plan ganz einfach: Reduzieren Sie die latencyReduziere deine Payloads und werde clever beim Caching. Wenn du diese drei Grundlagen meisterst, wirst du eine API haben, die nicht nur schnell und effizient ist, sondern auch ein zuverlässiges Erlebnis bietet, das die Nutzer zufriedenstellt und dein Geschäft voranbringt.

Warum die API-Leistung wichtiger ist als je zuvor

In der heutigen vernetzten Welt sind Anwendungen eng miteinander verbunden, und APIs sind die Fäden, die alles zusammenhalten. Eine langsame oder unzuverlässige API ist nicht nur eine kleine Unannehmlichkeit, die zu Verzögerungen führt. Sie hat direkte Auswirkungen auf die Nutzerbindung, die betriebliche Effizienz und das Ergebnis Ihres Unternehmens. Wenn eine API ins Stocken gerät, kann das massive Wellen schlagen und jeden einzelnen Dienst, der darauf angewiesen ist, beeinträchtigen.

Denken Sie nur an Ihre Mobile-Banking-App. Wenn der API-Aufruf zur Abfrage Ihres Kontostands zu lange dauert, schwindet Ihr Vertrauen in diese Bank. Oder stellen Sie sich eine E-Commerce-Website vor, auf der die API des Zahlungsgateways langsam ist – diese Verzögerung führt direkt zu abgebrochenen Warenkörben und verlorenen Verkäufen. Aus diesem Grund hat die Optimierung der API-Leistung sich von einer „schönen Zusatzfunktion“ zu einer zentralen Geschäftsstrategie entwickelt. Die Menschen erwarten sofortige Ergebnisse, und ihre Geduld für Verzögerungen ist nahezu verschwunden.

Die tatsächlichen Kosten von Ausfallzeiten

Bereits ein kleiner Rückgang Ihres Uptime-Prozentsatzes kann überraschend große Auswirkungen haben. Kürzlich haben wir einige besorgniserregende Daten gesehen: Zwischen Q1 2024 and Q1 2025Die durchschnittliche Verfügbarkeit der API ist tatsächlich auf 99,66 % to 99,46 %Es scheint, als wäre Ihre Nachricht unvollständig. Könnten Sie bitte den vollständigen Text bereitstellen, den Sie übersetzen möchten? 0,2 % „Drop“ mag vielleicht nicht viel bedeuten, aber es hat sich in eine beeindruckende Zahl verwandelt. 60 % Anstieg der Gesamtdowntime der API Jahr für Jahr. Das summiert sich auf fast neun zusätzliche Stunden Serviceausfälle pro Jahr. Wenn Sie die Zahlen selbst genauer betrachten möchten, finden Sie die Vollständige Analyse der API-Zuverlässigkeit von Uptrends.

Das folgende Diagramm verdeutlicht den jährlichen Wandel und zeigt, wie herausfordernd es geworden ist, eine hohe Verfügbarkeit aufrechtzuerhalten.

Diese Grafik verdeutlicht, dass ein scheinbar geringfügiger Rückgang der Leistungskennzahlen zu erheblichen Ausfallzeiten in der realen Welt führen kann.

„Jede Millisekunde zählt. In einer Welt, in der Dienstleistungen eng miteinander verknüpft sind, ist die Leistung Ihrer API die Leistung Ihres Unternehmens. Eine langsame API wird zum Engpass, der das Wachstum hemmt, das Vertrauen der Kunden untergräbt und Ihren Mitbewerbern einen Wettbewerbsvorteil verschafft.“

Letztendlich geht es hier nicht nur darum, eine API schneller zu machen, nur um der Geschwindigkeit willen. Es geht darum, einen Service zu schaffen, der widerstandsfähig, zuverlässig und skalierbar genug ist, um Ihre Geschäftsziele zu unterstützen. Dies erfordert eine proaktive Denkweise, die sich auf Folgendes konzentriert:

- Benutzererfahrung: Sorgen Sie dafür, dass jede App oder Dienstleistung, die auf Ihre API angewiesen ist, schnell und reaktionsschnell bleibt.

- Betriebliche Stabilität: Verhindern Sie, dass ein einzelner langsamer Endpunkt eine Kettenreaktion von Ausfällen in Ihrem System auslöst.

- Unternehmensreputation: Das Vertrauen Ihrer Nutzer sowie Ihrer Partner, die auf Ihre Dienstleistungen angewiesen sind, aufrechtzuerhalten.

Proaktiv an der Verbesserung der API-Leistung zu arbeiten, ist nicht nur eine technische Aufgabe – es ist eine entscheidende Investition in die langfristige Gesundheit und den Erfolg Ihres gesamten digitalen Betriebs.

Grundlegende Strategien für sofortige Leistungssteigerungen

Bevor Sie beginnen, Ihre Architektur zu überarbeiten oder Ihren gesamten Tech-Stack umzukrempeln, gibt es einige grundlegende Anpassungen, die erhebliche Leistungssteigerungen bringen können. Ich empfehle Entwicklern immer, hier zu beginnen. Das sind die wirkungsvollen, aber wenig aufwendigen Strategien, die Ihre erste Verteidigungslinie gegen Latenz und eine träge Benutzererfahrung bilden.

Betrachten Sie es so: Wenn Ihre API ein Lieferservice ist, dann sind diese Strategien wie die Optimierung Ihrer Routen und das Verkleinern Ihrer Pakete. So liefern Sie mehr, schneller, ohne einen größeren Lkw zu benötigen.

Meistern Sie die Kunst des Cachings

Eine der effektivsten Maßnahmen zur Geschwindigkeitssteigerung besteht darin, unnötige Arbeiten einfach zu vermeiden. Hier kommt das Caching ins Spiel. Caching bedeutet, die Ergebnisse kostenintensiver Operationen – wie einer umfangreichen Datenbankabfrage oder einer komplexen Berechnung – zu speichern und dieses Ergebnis für identische Anfragen, die später eintreffen, wiederzuverwenden. Anstatt bei jedem einzelnen Zugriff auf die gleichen Daten Ihre Backend-Server zu belasten, liefern Sie eine gespeicherte Kopie aus einem deutlich schnelleren Cache.

Ich habe gesehen, dass dies Wunder wirkt für Endpunkte, die statische oder selten wechselnde Daten bereitstellen, wie Benutzerprofile, Produktkataloge oder Konfigurationseinstellungen.

Durch die Implementierung intelligenter Caching-Mechanismen beschleunigen Sie nicht nur die Antwortzeiten, sondern reduzieren auch grundlegend die Belastung Ihrer gesamten Infrastruktur. Dadurch stehen wertvolle Ressourcen zur Verfügung, um die einzigartigen, dynamischen Anfragen zu bearbeiten, die tatsächlich Rechenleistung benötigen.

Effektives Caching hängt ganz davon ab, das richtige Werkzeug für die jeweilige Aufgabe auszuwählen. Verschiedene Szenarien erfordern unterschiedliche Strategien, jede mit ihren eigenen Vor- und Nachteilen.

Vergleich von Caching-Strategien und Anwendungsfällen

Hier ist eine kurze Übersicht über gängige Caching-Techniken, die ich verwendet habe, wo sie besonders gut funktionieren und worauf man achten sollte.

| Caching-Strategie | Am besten geeignet für | Pros | Cons |

|---|---|---|---|

| In-Memory-Cache | Kleine, häufig abgerufene Daten auf einem einzelnen Server (z. B. App-Einstellungen). | Extrem schnelle Zugriffszeiten; einfach zu implementieren. | Begrenzt durch den Server-RAM; Daten gehen beim Neustart verloren; nicht zwischen Instanzen geteilt. |

| Verteilter Cache | Hochfrequentierte Anwendungen mit mehreren Servern, die einen gemeinsamen Cache-Zustand benötigen. | Skalierbar; widerstandsfähig gegen Ausfälle einzelner Knoten; konsistente Daten über alle Dienste hinweg. | Aufwendiger in der Einrichtung und Wartung (z. B. Redis, Memcached). |

| CDN-Caching | Öffentlich zugängliche, statische Inhalte und API-Antworten (z. B. Bilder, öffentliche Produktdaten). | Reduziert die Latenz für globale Nutzer und entlastet die Ursprungsserver von Datenverkehr. | Kann teuer sein; Cache-Invalidierung kann kompliziert sein; nicht für private Daten geeignet. |

| HTTP-Caching | Clientseitiges Caching, um wiederholte Anfragen nach demselben Ressourcen zu verhindern. | Reduziert den Netzwerkverkehr vollständig und ermöglicht es dem Kunden, effizienter zu arbeiten. | Hängt von der Implementierung des Clients ab; weniger Kontrolle über den Cache-Zustand. |

Die Wahl der richtigen Strategie oder sogar einer Kombination davon kann einen enormen Unterschied darin machen, wie reaktionsschnell Ihre API für die Nutzer wirkt.

Optimieren Sie Ihre Payloads

Eine weitere große Quelle der Latenz ist die schiere Größe der Daten, die Sie über das Netzwerk senden. Es ist eine einfache Tatsache: Große, aufgeblähte Datenmengen benötigen länger für die Übertragung und länger, damit der Client sie verarbeiten kann. Jedes einzelne überflüssige Feld, das Sie senden, trägt zu dieser Verzögerung bei.

Hier sind meine beiden bevorzugten Methoden zur Reduzierung von Payloads:

- Datenkompression: Das ist ein Kinderspiel. Verwenden Sie gängige Komprimierungsalgorithmen wie Gzip or BrotliDiese Tools können die Größe von JSON- oder XML-Antworten erheblich reduzieren, manchmal um bis zu 70-80 %Die meisten Webserver und Clients unterstützen dies sofort mit nur wenigen Konfigurationsanpassungen.

- Feldfilterung: Senden Sie nicht gleich das ganze Paket, wenn der Kunde nur einen Löffel Zucker braucht. Geben Sie den Kunden die Möglichkeit, nur die benötigten Felder anzugeben. Dies ist ein zentrales Konzept in GraphQL, aber Sie können eine grundlegende Version ganz einfach in einer REST-API mit einem einfachen

fieldsAbfrageparameter.

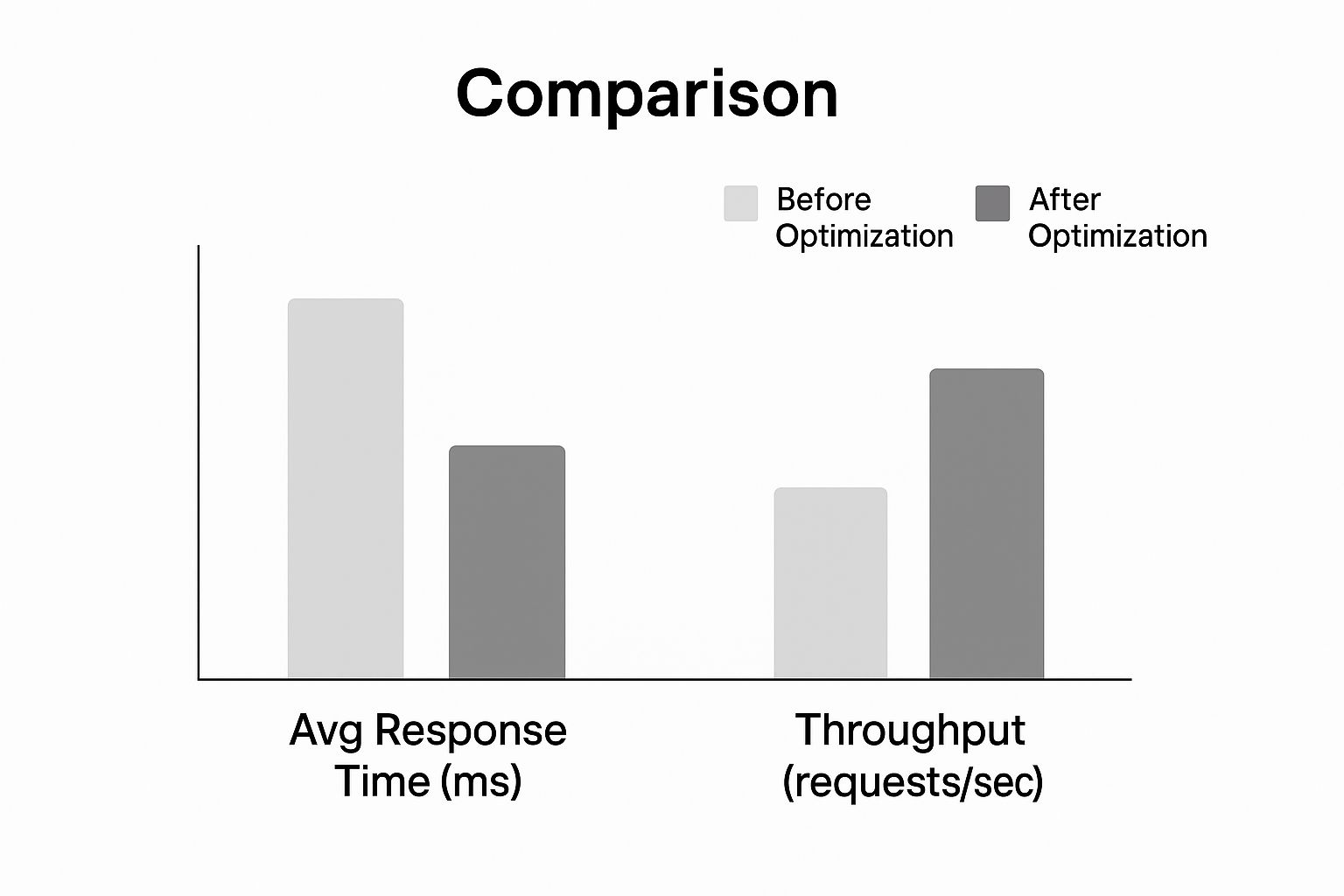

Schau dir nur an, welchen Einfluss diese Optimierungen auf die Reaktionszeit und den Durchsatz haben können.

Wie das Diagramm zeigt, führen diese grundlegenden Strategien zu einem dramatischen Rückgang der Antwortzeiten, während die API ein deutlich höheres Anfragevolumen bewältigen kann. Diese beiden Änderungen allein können Ihre API deutlich reaktionsschneller machen.

Für einen tieferen Einblick in verwandte Konzepte werfen Sie einen Blick in unseren Leitfaden zu Best Practices für die API-IntegrationIndem Sie diese Grundlagen beherrschen, legen Sie eine solide Leistungsbasis, bevor Sie überhaupt daran denken, komplexere architektonische Herausforderungen anzugehen.

Verkehrssteuerung mit intelligentem Raten-Limiting und Drosselung

So oder so wird eine unkontrollierte Flut von Anfragen selbst die widerstandsfähigsten APIs in die Knie zwingen. Ich habe es selbst erlebt. Ob durch ein fehlerhaftes Skript, einen plötzlichen viralen Moment oder einen böswilligen Akteur – unkontrollierter Datenverkehr stellt eine direkte Bedrohung für die Verfügbarkeit und Leistung Ihrer API dar. Genau aus diesem Grund ist die Implementierung intelligenter Ratenbegrenzung and throttling ist nicht nur eine gute Idee – es ist unverzichtbar.

Betrachten Sie diese Kontrollen als Verkehrsregeln für Ihre API. Sie setzen klare Vorgaben dafür, wie viele Anfragen ein Nutzer innerhalb eines bestimmten Zeitrahmens stellen kann, und schützen so Ihre Backend-Dienste vor Überlastung. Dies gewährleistet eine faire Nutzung für alle und verhindert, dass ein „lauter Nachbar“ das Erlebnis für Ihre anderen Nutzer beeinträchtigt.

Eine gut durchdachte Strategie zur Ratenbegrenzung ist Ihre erste Verteidigungslinie, um API-Leistung optimieren unter Druck. Es geht nicht nur darum, Anfragen blind abzulehnen; es geht darum, die Kapazität geschickt zu steuern, um Stabilität zu gewährleisten. Ohne diese Fähigkeit riskierst du eine Kaskade von Fehlern, die dein gesamtes System offline nehmen könnte.

Die Wahl des richtigen Begrenzungsalgorithmus

Nicht alle Strategien zur Ratenbegrenzung sind gleich. Der Algorithmus, den Sie wählen, beeinflusst direkt, wie flexibel und fair Sie den Datenverkehr steuern können. Lassen Sie uns die gängigsten Ansätze, die ich umgesetzt habe, näher betrachten und die realen Vor- und Nachteile jedes einzelnen analysieren.

- Festes Zeitfenster: Die einfachste Methode überhaupt. Sie zählt einfach die Anfragen eines Nutzers innerhalb eines festen Zeitfensters, wie 100 Anfragen pro Minute. Obwohl die Einrichtung einfach ist, kann es an den Rändern des Zeitfensters zu Verkehrsspitzen kommen. Ein Nutzer könnte... 100 Anfragen um 11:59:59 und eine weitere 100 um 12:00:00, wodurch sich ihr Limit effektiv verdoppelt.

- Gleitendes Fenster: Dieser Ansatz behebt das Problem der plötzlichen Anfragen, indem er stattdessen die Anfragen über ein gleitendes Zeitfenster verfolgt. Dadurch erhalten Sie eine viel genauere Rate-Limitierung, allerdings hat das seinen Preis – es erfordert mehr Datenspeicher und Rechenleistung, um dies aufrechtzuerhalten.

- Token-Bucket: Das ist meine bevorzugte Methode aufgrund ihrer Flexibilität. Jeder Nutzer erhält einen „Eimer“ von Tokens, der sich in einem gleichmäßigen Tempo auffüllt. Jede API-Anfrage verbraucht einen Token. Diese Regelung ermöglicht kurze Spitzen im Datenverkehr (solange genügend Tokens vorhanden sind), sorgt aber gleichzeitig für eine konstante durchschnittliche Rate über die Zeit, was hervorragend für die Nutzererfahrung ist.

Der Token-Bucket-Algorithmus eignet sich hervorragend für einen Dienst wie LATE. Ein Nutzer könnte beispielsweise eine Reihe von Social-Media-Posts gleichzeitig planen müssen, gefolgt von ruhigeren Phasen. Dieser Algorithmus berücksichtigt dieses legitime Nutzungsmuster, ohne die Stabilität des Systems zu gefährden.

Rate Limiting ist nicht nur eine defensive Maßnahme; es ist ein Werkzeug zur Beeinflussung des Nutzerverhaltens und zur Gewährleistung eines gerechten Zugangs zu Ihren API-Ressourcen. Eine durchdacht umgesetzte Richtlinie fördert Fairness und Vorhersehbarkeit für alle Nutzer.

Anpassung von Regeln für verschiedene Szenarien

Ein pauschales Rate-Limit funktioniert in der realen Welt einfach nicht. Um Ihre API wirklich zu schützen und gleichzeitig die Nutzer effektiv zu bedienen, müssen Sie granularer vorgehen und Ihre Regeln anpassen. Ein guter Ausgangspunkt ist die Implementierung unterschiedlicher Limits basierend auf den Abonnementstufen der Nutzer.

| Nutzerstufe | Beispiel für eine Rate-Limitierung | Anwendungsfall |

|---|---|---|

| Kostenloses Kontingent | 100 Anfragen/Stunde | Für Testnutzer und persönliche Projekte mit geringem Volumen. |

| Basis-Tarif | 1.000 Anfragen/Stunde | Für kleine Unternehmen und wachsende Anwendungen. |

| Enterprise-Stufe | 10.000 Anfragen/Stunde | Für Kunden mit hohem Volumen und geschäftskritischen Anforderungen. |

Dieser gestufte Ansatz schützt nicht nur Ihre Infrastruktur, sondern schafft auch einen klaren Upgrade-Weg für Benutzer, während sich ihre Anforderungen entwickeln. Sie können zudem spezifischer werden, indem Sie strengere Limits für ressourcenintensive Endpunkte (wie eine komplexe Datenbanksuche) festlegen, während Sie bei leichteren Endpunkten (wie einer einfachen Statusabfrage) großzügiger sind.

Für einen noch tiefergehenden Einblick in diese Strategien, werfen Sie einen Blick in unseren Leitfaden zu Best Practices für API-RatenlimitsDurch die Implementierung dieser intelligenten Steuerungen stellen Sie sicher, dass Ihre API schnell, fair und für alle zugänglich bleibt.

Architektur für Skalierbarkeit und eine globale Nutzerbasis

Wenn Sie gerade erst anfangen, erscheint eine Einzelserver-Konfiguration einfach und erfüllt ihren Zweck. Sie ist ideal für eine kleine, lokale Nutzerbasis. Doch was passiert, wenn Ihre App international durchstartet? Die einst zuverlässige Architektur verwandelt sich schnell in Ihr größtes Performance-Problem.

To API-Leistung optimieren Für ein wachsendes internationales Publikum sollten Sie aufhören, nur an einen einzelnen Server zu denken, und stattdessen ein verteiltes, globales System ins Auge fassen.

Der größte Feind hier ist latencyJede Anfrage eines Nutzers in Tokio an deinen Server in Virginia muss tausende von Kilometern zurücklegen, was Hunderte von Millisekunden Verzögerung hinzufügt, bevor dein Code überhaupt ausgeführt wird. Genau aus diesem Grund ist ein Inhaltsbereitstellungsnetzwerk (CDN) ist nicht nur ein nettes Extra; es ist unerlässlich. Ein CDN speichert die Antworten Ihrer API an „Edge“-Standorten auf der ganzen Welt, was bedeutet, dass Benutzer von einem geografisch nahen Server bedient werden, wodurch die Netzwerkübertragungszeit erheblich verkürzt wird.

Nutze horizontale Skalierung

Es geht nicht nur um die Distanz; es geht um das Volumen. Je mehr Nutzer auf Ihre API zugreifen, desto wichtiger wird eine Strategie, um die Last zu bewältigen. Hier kommt horizontale Skalierung kommt ins Spiel. Anstatt einen einzelnen Server aufzurüsten (vertikale Skalierung), fügen Sie Ihrer Flotte weitere Maschinen hinzu und verteilen die Arbeit auf diese.

Die Magie entfaltet sich mit einem LastenverteilerDieses Modul sitzt vor Ihren Servern und fungiert wie ein Verkehrspolizist, der eingehende Anfragen intelligent an die am wenigsten ausgelastete Maschine weiterleitet. So wird verhindert, dass ein einzelner Server überlastet wird, und es entsteht eine beeindruckende Ausfallsicherheit. Fällt ein Server aus? Kein Problem. Der Load Balancer leitet den Verkehr einfach an die funktionierenden Server um und hält Ihre API online.

Diese Strategie passt perfekt zu einem Mikroservices-ArchitekturIndem Sie Ihre große Anwendung in kleine, unabhängige Dienste aufteilen, können Sie nur die Teile skalieren, die es benötigen. Wenn beispielsweise Ihr Benutzeranmeldedienst während der Hauptnutzungszeiten stark beansprucht wird, können Sie einfach weitere Instanzen dieses Dienstes bereitstellen, ohne andere Komponenten zu beeinflussen.

Die Architektur für Skalierbarkeit bedeutet nicht nur, mehr Traffic zu bewältigen; es geht darum, ein widerstandsfähiges und anpassungsfähiges System zu schaffen. Durch die Verteilung Ihrer Daten und Rechenressourcen entwickeln Sie eine API, die für jeden Benutzer, unabhängig von seinem Standort, von Natur aus schneller und zuverlässiger ist.

Eine widerstandsfähige globale Präsenz aufbauen

Der Umstieg auf eine verteilte Architektur bedeutet fast immer, lokale Server hinter sich zu lassen und in eine flexible Cloud-Umgebung zu wechseln, die mit Ihnen wachsen kann. Die Architektur für ein globales Publikum erfordert, dass Sie Ihre Infrastruktur von Anfang an richtig gestalten. Wenn Sie neu in diesem Übergang sind, sollten Sie sich intensiver mit einem Expertenleitfaden für den Umzug von Servern in die Cloud kann eine große Hilfe sein.

Hier sind die entscheidenden Elemente, um eine widerstandsfähige globale Präsenz aufzubauen:

- Regionale Endpunkte: Setzen Sie nicht nur auf eine einzige Bereitstellung. Starten Sie Instanzen Ihrer API in mehreren geografischen Regionen wie Nordamerika, Europa und Asien. So können Sie Nutzer zu der Instanz leiten, die ihnen am nächsten ist, und die Latenzzeiten erheblich reduzieren.

- Datenbankreplikation: Eine einzige Datenbank kann zu einem erheblichen Engpass werden. Nutzen Sie Lese-Replikate in verschiedenen Regionen, um Daten lokal bereitzustellen. Dadurch werden leseintensive Vorgänge für Nutzer, die weit von Ihrer primären Datenbank entfernt sind, beschleunigt.

- Gesundheitsprüfungen: Konfigurieren Sie Ihren Load Balancer so, dass er Ihre Server kontinuierlich anpingt, um deren Gesundheit zu überprüfen. Wenn eine Instanz nicht mehr reagiert, wird der Load Balancer sie automatisch aus der Rotation entfernen, sodass Benutzer keine Fehler sehen.

Wenn Sie diese Strategien kombinieren, schaffen Sie ein leistungsstarkes, mehrschichtiges System. Das CDN kümmert sich um den ersten Kontaktpunkt, der Load Balancer verteilt die Last, und regionale Bereitstellungen sorgen dafür, dass die Verarbeitung so nah wie möglich am Nutzer erfolgt. Dies ist der Plan für jede API, die darauf abzielt, ein wachsendes, globales Publikum reibungslos zu bedienen.

Die Auswirkungen von Automatisierung und KI auf die API-Leistung

Es ist kein Geheimnis, dass künstliche Intelligenz das Spiel für unsere digitale Infrastruktur grundlegend verändert hat. Jeder Chatbot, jedes Datenanalysetool und jede neue KI-gestützte Funktion ist auf ein Netzwerk von APIs angewiesen, um ihre Aufgaben zu erfüllen. Dies hat einen Ansturm an Datenverkehr ausgelöst, den ältere, manuell verwaltete Systeme einfach nicht bewältigen können.

Wir sprechen hier nicht nur von einem kleinen Anstieg der Anfragen. Es handelt sich um ein völlig neues Paradigma. Diese KI-gesteuerte Explosion hat zu einem überwältigenden 73 % einen Anstieg der KI-bezogenen API-Aufrufe weltweit, was die Infrastruktur enorm belastet, um Schritt zu halten. Deshalb sind automatisierte API-Generierungsplattformen so wichtig, da sie die Entwicklungszeit um etwa 85 %werden immer wichtiger. Hier können Sie mehr darüber lesen, wie Der Boom der KI-APIs verstärkt den Bedarf an Automatisierung auf blog.dreamfactory.com.

Den Schritt über die manuelle Entwicklung hinaus wagen

In dieser neuen Realität ist die alte Methode, jede API manuell zu erstellen, bereitzustellen und zu verwalten, ein Auslaufmodell. Manuelle Prozesse sind langsam, anfällig für menschliche Fehler und können einfach nicht mit der Geschwindigkeit mithalten, die KI erfordert. Der Versuch, diese Komplexität von Hand zu bewältigen, führt zu enormen Engpässen, die Leistung und Innovation ersticken.

Automatisierung ist kein „Nice-to-have“ mehr; sie ist eine strategische Notwendigkeit. Wenn Sie den gesamten API-Lebenszyklus automatisieren – von der Erstellung und dem Testen bis hin zur Bereitstellung und Überwachung – schaffen Sie Dienste, die von Anfang an widerstandsfähiger, sicherer und skalierbarer sind.

Das Ziel ist nicht nur, APIs schneller zu erstellen. Es geht darum, Leistung und Sicherheit direkt in den Entwicklungsprozess zu integrieren, sodass Ihre Infrastruktur die hohen Anforderungen der KI-Ära bewältigen kann, ohne ständige manuelle Eingriffe.

Die Automatisierung des API-Managements ermöglicht es Ihnen, sich auf das Wesentliche zu konzentrieren: Mehrwert zu schaffen. Wenn Sie nicht mit repetitiven Wartungsaufgaben beschäftigt sind, können Sie innovativ sein. Ein hervorragendes Beispiel aus der Praxis ist die Optimierung von Outreach mit einem Marketing-Automatisierungs-API.

Der strategische Vorteil der automatisierten Erstellung

Der Aufstieg der KI hat uns auch Werkzeuge an die Hand gegeben, die die Backend-Entwicklung selbst vereinfachen. Wenn Sie genauer hinschauen, werden Sie sehen, wie No-Code-Backend-AI-Lösungen verändern die Landschaft grundlegend. Diese Plattformen treiben die Automatisierung noch weiter voran, indem sie produktionsbereite, hochwertige APIs mit minimalem Programmieraufwand erstellen.

Dieser Ansatz bietet Ihnen einige wesentliche Vorteile für Optimierung der API-LeistungEs scheint, dass Sie keine spezifischen Inhalte zum Übersetzen bereitgestellt haben. Bitte geben Sie den Text an, den Sie ins Deutsche übersetzen möchten, und ich helfe Ihnen gerne weiter!

- Beschleunigte Bereitstellung: Teams können neue APIs in einem Bruchteil der Zeit bereitstellen, die mit herkömmlichen Methoden erforderlich wäre. So können Sie schnell auf Marktveränderungen reagieren.

- Integrierte Best Practices: Diese Plattformen integrieren grundlegende Funktionen wie OAuth-Sicherheit, Ratenbegrenzung und Caching standardmäßig. Dadurch werden häufige Sicherheitslücken geschlossen, bevor sie überhaupt zu einem Problem werden können.

- Konsistente Skalierbarkeit: Auf diese Weise generierte APIs basieren in der Regel von Anfang an auf skalierbaren Architekturen, die bereit sind, den unvorhersehbaren Traffic zu bewältigen, den KI-Dienste verursachen können.

Letztendlich können Sie es sich nicht leisten, Automatisierung und KI in Ihrer API-Strategie zu ignorieren. Es ist der praktischste Weg, um die leistungsstarke, sichere und skalierbare Infrastruktur aufzubauen und zu pflegen, die Sie benötigen, um heute wettbewerbsfähig zu sein.

Häufige Fragen zur API-Leistung

Wenn Sie anfangen, die Leistung von APIs zu analysieren, werden Sie feststellen, dass immer wieder die gleichen Fragen auftauchen. Ich habe erlebt, wie selbst erfahrene Teams daran scheitern. Diese Fragen richtig zu beantworten, ist der entscheidende Unterschied zwischen einer API, die einfach funktioniert, und einer, die wirklich schnell und robust ist.

Lass uns einige der großen Themen angehen.

Zuerst: Caching. Jeder weiß, dass sie should Cache, aber die eigentliche Frage ist howEs geht nicht nur darum, einen Schalter umzulegen; es geht darum, die Caching-Strategie an Ihre spezifischen Daten anzupassen. Wenn Sie öffentliche, statische Daten an eine globale Nutzerbasis bereitstellen, dann... CDN ist ein Kinderspiel. Aber was ist mit Daten, die spezifisch für eine Benutzersitzung sind und über mehrere Server hinweg abgerufen werden müssen? Hier kommt ein verteilter Cache ins Spiel wie Redis leuchtet. Die wahre Expertise liegt im Verständnis des Lebenszyklus Ihrer Daten und wie auf sie zugegriffen wird.

Dann gibt es die knifflige Angelegenheit der Ratenbegrenzung. Wie schützt man seinen Dienst vor Missbrauch, ohne legitime Nutzer auszuschließen? Der Anfängerfehler ist eine pauschale Begrenzung für alle. Mach das nicht.

Ein gut durchdachtes Rate-Limit ist nicht nur ein Zugangskontrollsystem; es ist ein Leitfaden, der eine faire Nutzung fördert und gleichzeitig Ihre Infrastruktur schützt. Es sollte sich wie eine Leitplanke anfühlen, nicht wie eine Mauer.

Ein smarterer Ansatz ist differenziert. Beginnen Sie damit, unterschiedliche Limits für verschiedene Nutzergruppen festzulegen – Ihr kostenloser Plan sollte nicht denselben Zugang wie ein zahlender Unternehmenskunde haben. Gehen Sie noch einen Schritt weiter, indem Sie strengere Limits für Ihre teuersten Endpunkte anwenden. Ein komplexer Berichtsgenerierungsaufruf sollte deutlich niedrigere Schwellenwerte haben als ein einfacher. GET /status Das schützt Ihre leistungsstarken Ressourcen, ohne normale Aktivitäten zu benachteiligen.

Wann ist es Zeit, für Skalierung zu refaktorisieren?

Das könnte die wichtigste Frage überhaupt sein. Wann hörst du auf, nur zu reparieren, und fängst an, neu zu bauen? Die Antwort findest du fast immer in deinen Überwachungsdaten. Wenn deine Antwortzeiten langsam, aber sicher steigen, selbst nachdem du Abfragen optimiert und Caches hinzugefügt hast, ist das ein Zeichen. Wenn ein bestimmter Dienst während der Spitzenzeiten konstant bei 100 % CPU-Auslastung liegt, ist das ein weiteres Indiz.

Sie haben wahrscheinlich Ihre aktuelle Architektur überholt, wenn Sie diese eindeutigen Anzeichen bemerken:

- Persistente Latenz: Your and Die Latenzwerte sind hartnäckig hoch, selbst bei einfachen, alltäglichen Anfragen.

- Geografische Herausforderungen: Sie erhalten zunehmend Beschwerden von Nutzern in bestimmten Regionen, die weit von Ihren Servern entfernt sind, über langsame Leistung.

- Skalierbarkeitsengpässe: Eine einzelne Datenbank oder ein Dienst stößt jedes Mal an seine Ressourcen-Grenzen, wenn der Verkehr ansteigt.

Diese Muster zu erkennen, ist Ihr Zeichen. Es bedeutet, dass die kleinen Anpassungen nicht mehr ausreichen und es an der Zeit ist, in eine skalierbarere Architektur zu investieren. Das könnte bedeuten, auf horizontale Skalierung mit Lastverteilern umzusteigen, Ihre API in mehreren Regionen bereitzustellen oder endlich das Monolithen-System in Microservices zu zerlegen. Es ist ein großes Unterfangen, aber es ist der einzige Weg, um sicherzustellen, dass Ihre API langfristiges Wachstum bewältigen und zuverlässig bleiben kann.

Bereit, das Jonglieren mit mehreren Social-Media-APIs zu beenden? LATE bietet eine einheitliche API, um Inhalte über sieben große Plattformen hinweg zu planen. 99,97 % Verfügbarkeit und Sub-50 ms Antworten. Beginnen Sie noch heute kostenlos zu entwickeln!.