Ao trabalhar na melhoria do desempenho da sua API, o plano de ação é bastante simples: reduza o latencyreduza o tamanho dos seus payloads e otimize o uso de cache. Domine esses três fundamentos e você terá uma API que não apenas é rápida e eficiente, mas também oferece uma experiência confiável que mantém os usuários satisfeitos e seu negócio em crescimento.

Por que o desempenho da API é mais crítico do que nunca

No mundo em que vivemos, as aplicações estão todas interconectadas, e as APIs são os fios que mantêm tudo unido. Uma API lenta ou instável não é apenas um pequeno incômodo que causa um leve atraso. É um golpe direto na retenção de usuários, na eficiência operacional e no resultado financeiro da sua empresa. Quando uma API falha, pode gerar um efeito dominó massivo, degradando cada serviço que depende dela.

Pense na sua aplicação de banco móvel. Se a chamada da API para buscar o saldo da sua conta demora, sua confiança naquele banco começa a diminuir. Ou imagine um site de e-commerce onde a API do gateway de pagamento é lenta—essa demora leva diretamente a carrinhos abandonados e vendas perdidas. É por isso que otimizar o desempenho da API deixou de ser uma prática técnica "opcional" e se tornou uma estratégia central de negócios. As pessoas esperam que as coisas sejam instantâneas, e a paciência para atrasos praticamente desapareceu.

O Custo Real do Tempo de Inatividade

Até mesmo uma pequena queda na sua porcentagem de uptime pode ter consequências surpreendentemente grandes. Recentemente, observamos alguns dados bastante preocupantes: entre Q1 2024 and Q1 2025, o tempo médio de disponibilidade da API realmente caiu de 99,66% to 99,46%. Agora, um 0,2% "drop" pode não parecer muito, mas se traduz em um impressionante Aumento de 60% no tempo total de inatividade da API ano após ano. Isso resulta em quase nove horas extras de interrupções de serviço anualmente. Se você quiser analisar os números por conta própria, pode encontrar o análise completa da confiabilidade da API da Uptrends.

O gráfico abaixo realmente coloca essa mudança ano a ano em perspectiva, mostrando o quão desafiador se tornou manter uma alta disponibilidade.

Esta visualização enfatiza que uma aparente queda fracionária nos indicadores de desempenho pode se transformar em um tempo de inatividade significativo no mundo real.

"Cada milissegundo conta. Em um mundo onde os serviços estão profundamente interligados, o desempenho da sua API é o desempenho do seu negócio. Uma API lenta se torna um gargalo que limita o crescimento, erode a confiança do cliente e entrega uma vantagem competitiva aos seus concorrentes."

O objetivo aqui não é apenas tornar uma API mais rápida por causa da velocidade. Trata-se de construir um serviço que seja resiliente, confiável e escalável o suficiente para apoiar os objetivos do seu negócio. Isso requer uma mentalidade proativa que se concentra em:

- Experiência do Usuário: Garantindo que qualquer aplicativo ou serviço que dependa da sua API permaneça ágil e responsivo.

- Estabilidade Operacional: Impedir que um único ponto de extremidade lento cause uma reação em cadeia de falhas em todo o seu sistema.

- Reputação Empresarial: Manter a confiança tanto dos seus usuários quanto dos parceiros que dependem dos seus serviços.

Ser proativo na melhoria do desempenho da API não é apenas uma tarefa técnica—é um investimento crucial na saúde e no sucesso a longo prazo de toda a sua operação digital.

Estratégias Fundamentais para Ganhos de Performance Imediatos

Antes de começar a desmontar sua arquitetura ou reformular todo o seu stack tecnológico, há algumas pequenas alterações fundamentais que podem trazer ganhos de desempenho significativos. Sempre digo aos desenvolvedores para começarem por aqui. Estas são as estratégias de alto impacto e baixo esforço que servem como sua primeira linha de defesa contra a latência e uma experiência do usuário lenta.

Pense assim: se a sua API é um serviço de entrega, essas estratégias são como otimizar suas rotas e reduzir o tamanho dos seus pacotes. Você acaba entregando mais, mais rápido, sem precisar de um caminhão maior.

Domine a Arte do Cache

Uma das coisas mais poderosas que você pode fazer para aumentar a velocidade é simplesmente parar de realizar trabalhos desnecessários. É aí que entra o cache. O cache é a prática de armazenar os resultados de operações que consomem muitos recursos—como uma grande consulta a um banco de dados ou um cálculo complexo—e reutilizar esse resultado para solicitações idênticas que chegam posteriormente. Em vez de acessar seus servidores de backend toda vez para os mesmos dados, você serve uma cópia salva de um cache muito mais rápido.

Vi isso funcionar maravilhas para endpoints que servem dados estáticos ou que mudam com pouca frequência, como perfis de usuários, catálogos de produtos ou configurações.

Ao implementar um cache inteligente, você não está apenas acelerando as respostas; está reduzindo fundamentalmente a carga em toda a sua infraestrutura. Isso libera recursos valiosos para lidar com as solicitações únicas e dinâmicas que realmente precisam de poder de processamento.

O cache eficaz consiste em escolher a ferramenta certa para a tarefa. Diferentes cenários exigem estratégias distintas, cada uma com suas próprias compensações.

Comparando Estratégias de Cache e Casos de Uso

Aqui está uma breve explicação sobre as técnicas de cache comuns que utilizei, onde elas se destacam e o que é importante ficar atento.

| Estratégia de Cache | Melhor Para | Pros | Cons |

|---|---|---|---|

| Cache em Memória | Dados pequenos e frequentemente acessados em um único servidor (por exemplo, configurações do aplicativo). | Tempos de acesso extremamente rápidos; fácil de implementar. | Limitado pela RAM do servidor; os dados são perdidos na reinicialização; não compartilhados entre instâncias. |

| Cache Distribuído | Aplicações de alto tráfego com múltiplos servidores que necessitam de um estado de cache compartilhado. | Escalável; resistente a falhas de um único nó; dados consistentes entre serviços. | Mais complexo de configurar e manter (por exemplo, Redis, Memcached). |

| Cache de CDN | Ativos estáticos acessíveis publicamente e respostas de API (por exemplo, imagens, dados de produtos públicos). | Reduz a latência para usuários globais; descarrega o tráfego dos servidores de origem. | Pode ser caro; a invalidação de cache pode ser complicada; não é adequado para dados privados. |

| Cache HTTP | Cache do lado do cliente para evitar solicitações repetidas pelo mesmo recurso. | Reduz o tráfego da rede de forma total; capacita o cliente a ser mais eficiente. | Depende da implementação do cliente; menos controle sobre o estado do cache. |

Escolher a estratégia certa, ou até mesmo uma combinação delas, pode fazer uma diferença enorme na forma como sua API é percebida pelos usuários.

Otimize Seus Payloads

Outra grande fonte de latência é o tamanho dos dados que você está enviando pela rede. É um fato simples: cargas úteis grandes e inchadas demoram mais para serem transmitidas e mais tempo para o cliente processar. Cada campo desnecessário que você envia aumenta esse atraso.

Aqui estão meus dois métodos favoritos para reduzir cargas úteis:

- Compressão de Dados: Isso é uma decisão óbvia. Utilize algoritmos de compressão padrão, como Gzip or Brotli. Essas ferramentas podem reduzir o tamanho das respostas JSON ou XML, às vezes em até 70-80%A maioria dos servidores web e clientes suporta isso de forma nativa com apenas algumas alterações de configuração.

- Filtragem de Campos: Não envie toda a cozinha quando o cliente só precisa de uma xícara de açúcar. Dê aos clientes uma maneira de especificar apenas os campos que precisam. Este é um conceito fundamental em GraphQL, mas você pode implementar facilmente uma versão básica em uma API REST com um simples

fieldsparâmetro de consulta.

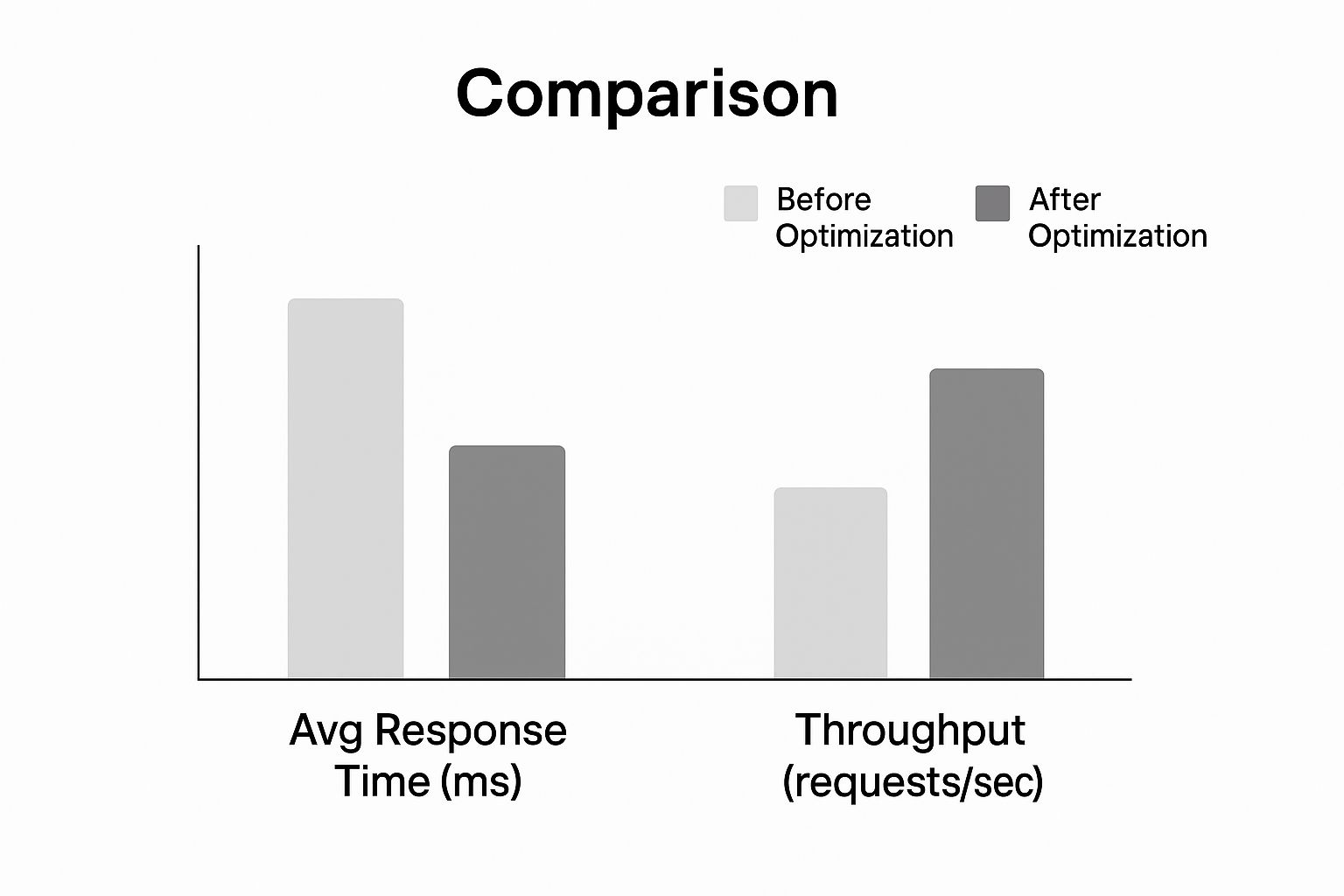

Veja o tipo de impacto que essas otimizações podem ter no tempo de resposta e na capacidade de processamento.

Como o gráfico mostra, aplicar essas estratégias fundamentais resulta em uma queda dramática nos tempos de resposta, permitindo que a API gerencie um volume muito maior de solicitações. Essas duas mudanças sozinhas podem fazer com que sua API pareça muito mais ágil.

Para uma análise mais aprofundada de conceitos relacionados, confira nosso guia sobre Melhores práticas para integração de APIAo dominar esses fundamentos, você estabelecerá uma base sólida de desempenho antes mesmo de considerar enfrentar desafios arquitetônicos mais complexos.

Controlando o Tráfego com Limitação de Taxa Inteligente e Controle de Fluxo

Mais cedo ou mais tarde, um fluxo descontrolado de solicitações derrubará até mesmo a API mais resiliente. Já vi isso acontecer. Seja por causa de um script fora de controle, um momento viral repentino ou um ator malicioso, o tráfego descontrolado é uma ameaça direta à disponibilidade e ao desempenho da sua API. É exatamente por isso que implementar soluções inteligentes limitação de taxa and throttling não é apenas uma boa ideia—é algo inegociável.

Considere esses controles como guardas de trânsito para sua API. Eles impõem regras claras sobre quantas solicitações um usuário pode fazer em um determinado período, protegendo seus serviços de backend de serem sobrecarregados. Isso garante um uso justo para todos e impede que um "vizinho barulhento" estrague a experiência para os demais usuários.

Uma estratégia de limitação de taxa bem elaborada é sua primeira linha de defesa para melhorar o desempenho da API sob pressão. Não se trata apenas de rejeitar pedidos de forma cega; é sobre gerenciar a capacidade de maneira elegante para manter a estabilidade. Sem isso, você corre o risco de uma cascata de falhas que pode derrubar todo o seu sistema.

Escolhendo o Algoritmo de Limitação Adequado

Nem todas as estratégias de limitação de taxa são iguais. O algoritmo que você escolher impacta diretamente a flexibilidade e a justiça com que você pode gerenciar o tráfego. Vamos analisar as abordagens mais comuns que implementei e os trade-offs reais de cada uma.

- Janela Fixa: O método mais simples que existe. Ele apenas conta as solicitações de um usuário dentro de uma janela de tempo estática, como 100 requisições por minuto. Embora seja fácil de configurar, pode causar picos de tráfego na borda da janela. Um usuário pode fazer 100 pedidos às 11:59:59 e outro 100 às 12:00:00, dobrando efetivamente seu limite.

- Janela Deslizante: Essa abordagem suaviza o problema de picos ao rastrear solicitações ao longo de uma janela de tempo contínua. Isso oferece um limite de taxa muito mais preciso, mas tem um custo—exige mais armazenamento de dados e poder computacional para ser mantido.

- Token Bucket: Este é o meu método preferido pela sua flexibilidade. Cada usuário recebe um "balde" de tokens que se reabastece a uma taxa constante. Cada solicitação de API consome um token. Essa configuração permite picos breves de tráfego (desde que você tenha tokens), mas impõe uma taxa média consistente ao longo do tempo, o que é fantástico para a experiência do usuário.

O algoritmo do balde de tokens, por exemplo, é ideal para um serviço como o LATE. Um usuário pode precisar agendar uma série de postagens em redes sociais de uma só vez, mas depois ter períodos mais tranquilos. Esse algoritmo se adapta a esse padrão de uso legítimo sem comprometer a saúde do sistema.

A limitação de taxa não é apenas uma medida defensiva; é uma ferramenta para moldar o comportamento do usuário e garantir acesso equitativo aos recursos da sua API. Uma política bem implementada melhora a equidade e a previsibilidade para todos os consumidores.

Regras Personalizadas para Diferentes Cenários

Um limite de taxa único não funciona no mundo real. Para realmente proteger sua API enquanto atende os usuários de forma eficaz, é necessário ser mais específico e personalizar suas regras. Um ótimo ponto de partida é implementar limites diferentes com base nos níveis de assinatura dos usuários.

| Nível de Usuário | Exemplo de Limite de Taxa | Caso de Uso |

|---|---|---|

| Camada Gratuita | 100 requisições/hora | Para usuários em teste e projetos pessoais de baixo volume. |

| Plano Básico | 1.000 requisições/hora | Para pequenas empresas e aplicações em crescimento. |

| Camada Empresarial | 10.000 requisições/hora | Para clientes de alto volume com necessidades críticas. |

Essa abordagem em camadas não apenas protege sua infraestrutura, mas também cria um caminho de atualização claro para os usuários à medida que suas necessidades crescem. Você também pode ser mais específico aplicando limites mais rigorosos a pontos de extremidade que consomem muitos recursos (como uma busca complexa em banco de dados) enquanto é mais generoso com aqueles que são leves (como uma simples verificação de status).

Para uma análise ainda mais aprofundada dessas estratégias, confira nosso guia sobre Melhores práticas para limites de taxa da APIAo implementar esses controles inteligentes, você pode garantir que sua API permaneça rápida, justa e disponível para todos.

Arquitetando para Escala e uma Base de Usuários Global

Quando você está começando, uma configuração de servidor único parece simples e atende às necessidades. É perfeita para uma base de usuários pequena e local. Mas o que acontece quando seu aplicativo começa a ganhar destaque globalmente? Aquela arquitetura antes confiável rapidamente se transforma na sua maior dor de cabeça em termos de desempenho.

To melhorar o desempenho da API Para um público internacional em crescimento, você precisa parar de pensar em um único servidor e começar a pensar em um sistema distribuído e global.

O inimigo número um aqui é latency. Cada solicitação de um usuário em Tóquio para seu servidor na Virgínia precisa percorrer milhares de milhas, adicionando centenas de milissegundos de latência antes que seu código comece a ser executado. É exatamente por isso que um Rede de Distribuição de Conteúdo (CDN) não é apenas um recurso desejável; é essencial. Um CDN armazena em cache as respostas da sua API em locais "edge" ao redor do mundo, o que significa que os usuários são atendidos por um servidor geograficamente próximo, reduzindo o tempo de viagem da rede.

Adote a Escalabilidade Horizontal

Não se trata apenas de distância; é sobre volume. À medida que mais usuários acessam sua API, você precisa de uma estratégia para gerenciar a carga. É aqui que escalabilidade horizontal entra em cena. Em vez de aumentar a capacidade de um único servidor (escalonamento vertical), você adiciona mais máquinas à sua frota, distribuindo o trabalho entre elas.

A mágica acontece com um balanceador de cargaEste componente fica à frente dos seus servidores, funcionando como um controlador de tráfego, direcionando de forma inteligente as solicitações recebidas para a máquina menos ocupada. Isso evita que um único servidor fique sobrecarregado e constrói uma resiliência incrível. Se um servidor falhar? Sem problemas. O balanceador de carga simplesmente redireciona o tráfego para os servidores saudáveis, mantendo sua API online.

Esta estratégia é uma combinação perfeita para um arquitetura de microserviçosAo dividir sua grande aplicação em pequenos serviços independentes, você pode escalar apenas as partes que precisam. Por exemplo, se o seu serviço de login de usuário estiver sobrecarregado durante os horários de pico, você pode criar mais instâncias apenas desse serviço sem afetar nada mais.

Arquitetar para escalar não se trata apenas de lidar com mais tráfego; é sobre construir um sistema resiliente e adaptável. Ao distribuir tanto seus dados quanto seus recursos de computação, você cria uma API que é intrinsecamente mais rápida e confiável para cada usuário, independentemente de onde ele esteja.

Construindo uma Presença Global Resiliente

Migrar para uma arquitetura distribuída quase sempre significa deixar para trás servidores locais em prol de um ambiente de nuvem flexível que possa crescer com você. Projetar para um público global significa acertar sua infraestrutura desde o início. Se você é novo nessa transição, mergulhar em um guia especializado para migrar servidores para a nuvem pode ser de grande ajuda.

Aqui estão os elementos-chave para construir uma presença global resiliente:

- Endpoints Regionais: Não se limite a uma única implementação. Crie instâncias da sua API em várias regiões geográficas, como América do Norte, Europa e Ásia. Isso permite direcionar os usuários para a instância mais próxima, reduzindo drasticamente a latência.

- Replicação de Banco de Dados: Um único banco de dados pode se tornar um grande gargalo. Utilize réplicas de leitura em diferentes regiões para servir dados localmente. Isso acelera operações com alta leitura para usuários distantes do seu banco de dados principal.

- Verificações de Saúde: Configure o seu balanceador de carga para verificar constantemente a saúde dos seus servidores. Se uma instância ficar sem resposta, o balanceador de carga a removerá automaticamente da rotação, evitando que os usuários vejam erros.

Ao combinar essas estratégias, você cria um sistema poderoso e multifacetado. A CDN lida com o primeiro ponto de contato, o balanceador de carga distribui o trabalho e as implantações regionais garantem que o processamento ocorra o mais próximo possível do usuário. Este é o modelo para qualquer API que busca atender a um público global em crescimento sem contratempos.

O Impacto da Automação e da IA no Desempenho da API

Não é segredo que a inteligência artificial transformou completamente o cenário da nossa infraestrutura digital. Cada chatbot, cada ferramenta de análise de dados, cada nova funcionalidade impulsionada por IA depende de uma rede de APIs para funcionar. Isso gerou um fluxo intenso de tráfego que os sistemas mais antigos, geridos manualmente, simplesmente não estão preparados para suportar.

Não estamos apenas falando de um pequeno aumento nas solicitações. É um novo paradigma. Essa explosão impulsionada por IA causou um impacto impressionante. 73% um aumento nas chamadas de API relacionadas à IA em todo o mundo, colocando uma pressão incrível na infraestrutura para acompanhar. É por isso que plataformas de geração de API automatizadas, que podem reduzir o tempo de desenvolvimento em cerca de 85%, estão se tornando tão essenciais. Você pode ler mais sobre como O boom das APIs de IA reforça essa necessidade de automação em blog.dreamfactory.com.

Avançando Além do Desenvolvimento Manual

Nesta nova realidade, a antiga forma de fazer as coisas—construir, implantar e gerenciar cada API manualmente—é um beco sem saída. Processos manuais são lentos, cheios de potencial para erros humanos e simplesmente não conseguem acompanhar a velocidade que a IA exige. Tentar gerenciar essa complexidade manualmente cria gargalos enormes que prejudicam o desempenho e a inovação.

A automação deixou de ser um "desejo"; agora é uma necessidade estratégica. Ao automatizar todo o ciclo de vida da API—desde a criação e testes até a implementação e monitoramento—você cria serviços que são mais resilientes, seguros e escaláveis desde o início.

O objetivo não é apenas construir APIs mais rapidamente. É incorporar desempenho e segurança diretamente no processo de desenvolvimento, garantindo que sua infraestrutura possa lidar com as intensas demandas da era da IA sem a necessidade de intervenção manual constante.

A automação da gestão de API permite que você se concentre no que realmente importa: entregar valor. Quando você não está preso em tarefas repetitivas de manutenção, pode inovar. Um excelente exemplo prático é a simplificação do contato com um API de automação de marketing.

A Vantagem Estratégica da Geração Automatizada

O surgimento da IA também nos proporcionou ferramentas que simplificam o desenvolvimento de backend. Se você investigar mais a fundo, verá como soluções de IA backend sem código estão a transformar completamente o panorama. Estas plataformas levam a automação ainda mais longe ao gerar APIs de alta qualidade, prontas para produção, com muito pouco código manual.

Esta abordagem oferece algumas vantagens importantes para melhorando o desempenho da API:

- Implantação Acelerada: As equipas podem lançar novas APIs em uma fração do tempo que levariam com métodos tradicionais. Isso permite que você reaja rapidamente às mudanças do mercado.

- Práticas recomendadas integradas: Essas plataformas incorporam funcionalidades essenciais como segurança OAuth, limitação de taxa e cache por padrão. Isso fecha brechas de segurança comuns antes que possam se tornar um problema.

- Escalabilidade Consistente: APIs gerados dessa forma geralmente são construídos com arquiteturas escaláveis desde o início, prontos para lidar com o tráfego imprevisível que os serviços de IA podem gerar.

No final das contas, você não pode se dar ao luxo de ignorar a automação e a IA na sua estratégia de API. É a forma mais prática de construir e manter a infraestrutura de alto desempenho, segura e escalável que você precisa para competir hoje.

Perguntas Frequentes Sobre o Desempenho da API

Ao começar a investigar o desempenho da API, você perceberá que as mesmas perguntas surgem repetidamente. Já vi essas questões deixarem até equipes experientes sem resposta. Acertar nesses pontos é a diferença entre uma API que apenas funciona e uma que é realmente rápida e resiliente.

Vamos abordar alguns dos principais.

Primeiro, vamos falar sobre caching. Todos sabem que eles should cache, mas a verdadeira pergunta é howNão se trata apenas de ativar um interruptor; é sobre alinhar a estratégia de cache aos seus dados específicos. Se você está disponibilizando dados públicos e estáticos para uma base de usuários global, um CDN é uma escolha óbvia. Mas e os dados que são específicos de uma sessão de usuário e precisam ser acessados em múltiplos servidores? É aí que entra um cache distribuído como Redis brilha. A verdadeira especialização está em compreender o ciclo de vida dos seus dados e como eles são acessados.

Depois, há o complicado assunto da limitação de taxa. Como proteger seu serviço contra abusos sem isolar usuários legítimos? O erro comum é aplicar um limite único para todos. Não faça isso.

Um limite de taxa bem projetado não é apenas um guardião; é um guia que incentiva o uso justo enquanto protege sua infraestrutura. Deve parecer uma proteção, não uma barreira intransponível.

Uma abordagem mais inteligente é sutil. Comece definindo limites diferentes para os vários níveis de usuários—seu plano gratuito não deve ter o mesmo acesso que um cliente corporativo que paga alto. Torne-se ainda mais específico aplicando limites mais rigorosos aos seus pontos finais mais caros. Uma chamada de geração de relatórios complexa deve ter um limite muito mais baixo do que uma simples. GET /status verifique. Isso protege seus recursos de alto desempenho sem penalizar a atividade normal.

Quando é o momento de refatorar para escalar?

Esta pode ser a maior pergunta de todas. Quando você deve parar de corrigir e começar a reconstruir? A resposta está quase sempre nos seus dados de monitoramento. Se os seus tempos de resposta estão subindo lenta mas seguramente, mesmo depois de você ter otimizado as consultas e adicionado caches, isso é um sinal. Se um serviço específico está constantemente com 100% de CPU durante as horas de pico, isso é outro sinal.

Você provavelmente superou a arquitetura atual quando perceber estes sinais reveladores:

- Latência Persistente: Your p95 and p99 As métricas de latência estão persistentemente elevadas, mesmo para solicitações simples do dia a dia.

- Pontos de Dor Geográficos: Você começa a receber reclamações consistentes sobre a lentidão do desempenho de usuários em regiões específicas distantes dos seus servidores.

- Gargalos de Escalabilidade: Um único banco de dados ou serviço atinge constantemente o limite de seus recursos sempre que há um pico de tráfego.

Identificar esses padrões é o seu sinal. Isso significa que as pequenas alterações já não são suficientes e é hora de investir em uma arquitetura mais escalável. Isso pode significar migrar para escalabilidade horizontal com balanceadores de carga, implantar sua API em várias regiões ou finalmente dividir aquele monólito em microserviços. É uma tarefa significativa, mas é a única maneira de garantir que sua API possa lidar com o crescimento a longo prazo e se manter confiável.

Pronto para parar de equilibrar várias APIs de redes sociais? LATE oferece uma única API unificada para agendar conteúdo em sete plataformas principais com 99,97% tempo de atividade e sub-50ms respostas. Comece a construir gratuitamente hoje mesmo..