Quando si riduce tutto all'essenziale, l'efficacia Limitazione della velocità dell'API si tratta di creare un'esperienza equa, stabile e sicura per tutti gli utenti del tuo servizio. Mi piace pensarlo come un sistema di prenotazione per un ristorante molto frequentato: evita che la cucina venga sopraffatta e garantisce che ogni ospite si diverta.

Che cos'è il rate limiting delle API e perché è importante

Immagina che la tua API sia la porta d'ingresso digitale ai dati e alle funzionalità della tua applicazione. Se lasci quella porta spalancata senza alcun controllo, chiunque potrebbe entrarci all'improvviso. Potrebbe essere un sviluppatore benintenzionato con uno script fuori controllo, un utente esperto con richieste elevate, o addirittura un malintenzionato che cerca di mettere in ginocchio il tuo servizio.

Il rate limiting è come un buttafuori all'ingresso di un locale digitale. Ma non si tratta di allontanare le persone in modo scortese. Si tratta di gestire il flusso di traffico per proteggere i tuoi sistemi backend, garantire stabilità e assicurare un accesso equo per tutti. Stabilisce semplicemente regole chiare su quante richieste un utente può effettuare in un determinato periodo.

I Pilastri Fondamentali del Rate Limiting

Il rate limiting non è solo un trucco isolato; è una strategia difensiva che sostiene diversi obiettivi aziendali chiave.

- Prevenire il degrado del servizio: Tutti noi abbiamo visto accadere situazioni del genere. Un ciclo infinito accidentale in uno script o un'integrazione troppo aggressiva possono mettere a dura prova i tuoi server, rallentando o addirittura mandando in crash il tuo servizio. all I limiti di utilizzo fungono da interruttore di sicurezza, bloccando questo tipo di utilizzo eccessivo prima che possa causare danni reali.

- Migliorare la Sicurezza: La sicurezza è un motivo fondamentale per implementare il rate limiting, soprattutto in settori sensibili come quello finanziario. Monitorando metriche come le richieste al secondo e quali endpoint vengono colpiti di più, puoi iniziare a distinguere tra l'attività normale degli utenti e un attacco malevolo come un DDoS (Distributed Denial of Service) o un tentativo di accesso brute-force.

- Garantire un'allocazione equa delle risorse: In un sistema con più utenti, è naturale che alcuni utilizzino più risorse di altri. Il rate limiting aiuta a garantire un equilibrio, assicurando che un utente ad alto volume non possa monopolizzare tutte le risorse e compromettere l'esperienza per gli altri. Questo è particolarmente importante per le API che offrono piani a livelli (ad esempio, Gratuito, Pro, Enterprise).

- Gestire i Costi Operativi: Ogni singola chiamata API che gestisci consuma risorse: cicli della CPU, memoria e larghezza di banda, e tutte queste cose hanno un costo. Impostando un limite sul volume delle richieste, puoi prevedere e gestire meglio le spese per la tua infrastruttura.

Punto Chiave: Il rate limiting non riguarda tanto il dire "no", quanto piuttosto garantire che la tua API possa costantemente dire "sì" a richieste legittime senza crollare sotto pressione.

Osservando come funzionano le diverse API nel mondo reale, come un API di verifica emailsottolinea davvero l'importanza del rate limiting per prevenire abusi e mantenere il servizio affidabile. Comprendere correttamente questo concetto è il primo passo per costruire un'applicazione resiliente e scalabile su cui sviluppatori e utenti possano davvero contare.

Scegliere il Giusto Algoritmo di Limitazione della Frequenza

Scegliere il giusto algoritmo di limitazione del tasso è come scegliere lo strumento giusto per un lavoro. Una strategia progettata per un flusso costante di richieste cederà sotto la pressione di un'improvvisa ondata di traffico. Non useresti un martello per avvitare una vite, giusto? Allo stesso modo, l'algoritmo che scegli deve adattarsi ai modelli di traffico specifici della tua API e al tipo di esperienza che desideri creare per gli sviluppatori.

Comprendere il funzionamento di ciascun algoritmo è fondamentale per costruire una strategia di limitazione della frequenza che funzioni davvero, proteggendo il tuo sistema e trattando ogni utente in modo equo.

Finestra Fissa e Finestra Scorrevole

The Finestra Fissa l'algoritmo è il più semplice del gruppo. Pensalo come un contatore che si azzera ogni minuto o ogni ora. Se il tuo limite è 100 richieste al minuto, il sistema conta semplicemente i colpi al secondo 0 to 59, poi ricomincia da zero per il minuto successivo.

È semplice da configurare, ma presenta una debolezza evidente. Un'improvvisa ondata di richieste proprio alla fine di una finestra e all'inizio della successiva può superare il limite e sovraccaricare il tuo server.

The Finestra Scorrevole L'algoritmo è stato progettato per risolvere proprio questo problema. Offre un modo molto più fluido e preciso per limitare le richieste, monitorando le richieste in un intervallo di tempo in continuo movimento. Invece di un reset rigido, si basa su una media mobile, che previene quei picchi di traffico anomali che affliggono le finestre fisse. Questo ti offre una protezione migliore, ma richiede un po' più di lavoro per essere implementato.

Token Bucket e Leaky Bucket

The Token Bucket L'algoritmo è probabilmente una delle opzioni più popolari e flessibili disponibili. Immagina un secchio che viene costantemente riempito di token a un ritmo regolare. Ogni richiesta API consuma un token. Se il secchio è vuoto, la richiesta viene rifiutata.

Questo modello è fantastico per gestire il traffico improvviso. Consente agli utenti di utilizzare un gran numero di token in un colpo solo per affrontare picchi temporanei, purché la loro media rimanga entro i limiti stabiliti.

D'altra parte, il Secchiello Forato L'algoritmo elabora le richieste a una velocità fissa e costante: immagina un imbuto con un piccolo foro sul fondo. Le richieste vengono aggiunte a una coda (il secchio) e il server le gestisce una alla volta. Se la coda si riempie, le nuove richieste vengono semplicemente scartate. Questo approccio garantisce un flusso di traffico prevedibile e costante dal tuo API, ma non è particolarmente efficace nel gestire picchi di richieste.

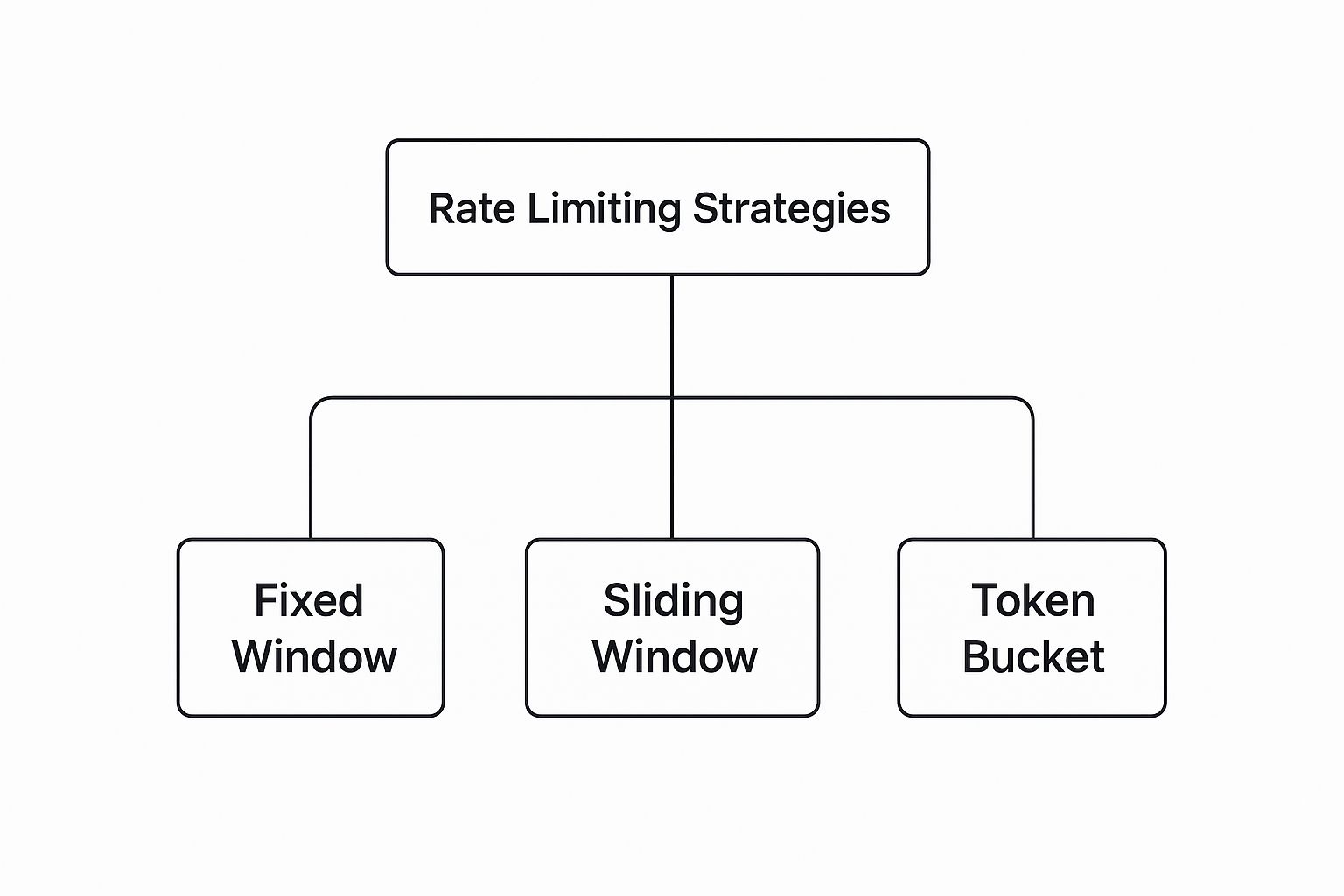

Ecco una rapida panoramica di come sono organizzate queste strategie popolari.

Come puoi vedere, sebbene esistano diverse strategie, opzioni flessibili come il Token Bucket sono spesso preferite per la loro capacità di gestire i modelli di traffico del mondo reale.

Confronto tra gli algoritmi di limitazione della velocità

Per rendere la scelta più chiara, è utile vedere questi algoritmi a confronto. Ognuno ha i propri punti di forza ed è adatto a scenari diversi.

| Algorithm | Ideale per | Pros | Cons |

|---|---|---|---|

| Finestra Fissa | Semplicità e casi d'uso fondamentali. | Facile ed economico da implementare. Basso utilizzo di memoria. | Può gestire picchi di traffico ai margini della finestra. |

| Finestra Scorrevole | Controllo del traffico più fluido e prevenzione dei picchi. | Limitazione della velocità più precisa. Evita problemi in situazioni particolari. | Maggiore complessità di implementazione e utilizzo della memoria. |

| Token Bucket | API che devono gestire un traffico intenso in modo equo. | Flessibile, consente picchi di attività, ottima esperienza utente. | Può essere più complesso ottimizzare il tasso di riempimento dei token. |

| Secchiello Forato | Sistemi che richiedono un flusso di traffico costante e prevedibile. | Ottimizza il flusso di traffico. Carico del server prevedibile. | Non gestisce i picchi; potrebbe causare la perdita di richieste. |

In definitiva, questa tabella dimostra che non esiste un algoritmo "migliore" in assoluto: tutto dipende da ciò che vuoi ottenere con la tua API.

Scegliere un algoritmo non è solo una decisione tecnica; è una scelta di prodotto che influisce direttamente sull'esperienza dell'utente. Un algoritmo ben scelto appare equo e prevedibile, mentre una scelta sbagliata può generare frustrazione nei sviluppatori.

I moderni gateway API consentono spesso di configurare diverse opzioni, e molti servizi ora utilizzano anche limiti dinamici che si adattano in base al carico del server.

La scelta migliore dipende sempre dalle tue esigenze specifiche. Fare la scelta giusta è fondamentale per costruire integrazioni solide e affidabili. Puoi saperne di più leggendo la nostra guida su Migliori pratiche per l'integrazione delle API.

Come impostare limiti di utilizzo efficaci e equi

Stabilire il giusto limite di richieste non è un gioco d'azzardo. Se prendi un numero a caso, stai solo preparando il terreno per problemi futuri. Si tratta di un delicato equilibrio strategico. L'obiettivo è trovare quel punto ideale in cui la tua infrastruttura è protetta da sovraccarichi, ma gli sviluppatori che utilizzano la tua API possono comunque godere di un'esperienza fluida e prevedibile.

Prima di poter stabilire dei limiti per gli altri, è fondamentale comprendere i tuoi. Inizia a guardare dentro il tuo sistema e valuta la sua capacità. Analizza le metriche di prestazione del tuo server: utilizzo della CPU, consumo di memoria, carico del database—sotto diversi scenari di traffico. Questo ti fornisce una chiara base di riferimento su ciò che il tuo sistema può realmente gestire prima che le cose inizino a rompersi.

Una volta che hai identificato i tuoi punti critici, rivolgiti ai tuoi utenti. Analizza il loro comportamento per comprendere cosa significhi realmente un utilizzo "normale". Quante richieste effettua un utente medio durante una sessione? Quali sono le tue ore di punta? Un approccio basato sui dati come questo è l'unico modo per stabilire limiti che sembrino equi e che non blocchino accidentalmente utenti legittimi.

Definisci il tuo ambito di limitazione delle richieste

Imporre un limite universale è un errore classico da principianti. Non tutte le richieste sono uguali, quindi è necessario prendere una decisione. how Traccerai l'utilizzo e applicherai i tuoi limiti.

- Chiave API per utente: Questo è il modo più comune e, francamente, il più equo per farlo. Colleghi i limiti direttamente a un utente autenticato o al suo API key unico. In questo modo, un utente esperto non può compromettere l'esperienza per gli altri.

- Per indirizzo IP: Questa è un'opzione valida per il traffico non autenticato, in cui limiti le richieste provenienti da un singolo IP. Fai attenzione, però. Potrebbe diventare complicato, poiché più utenti in un ufficio o su una rete pubblica potrebbero condividere lo stesso IP.

- Limite Globale: Consideralo come la tua ultima linea di difesa. Si tratta di un limite ampio, progettato per proteggere l'intera infrastruttura da un'improvvisa e massiccia ondata di traffico. Non si tratta tanto di equità individuale, quanto di pura sopravvivenza.

Uno dei più importanti pratiche migliori per il limite di utilizzo delle API è possibile personalizzare i limiti in base ai diversi livelli di abbonamento. Molti servizi importanti adottano questa pratica. Ad esempio, un utente gratuito potrebbe ricevere 1.000 richieste al giorno, mentre un utente premium pagante ha una soglia di molto superiore a 100.000 richieste. Questo approccio supporta il tuo modello di business mantenendo stabile la tua infrastruttura. Puoi approfondire come funzionano i limiti a livelli in questa guida dettagliata su Orq.ai.

Inizia con cautela e poi migliora.

Quando lanci i tuoi limiti per la prima volta, è meglio andare sul sicuro. Inizia con un numero più conservativo. Perché? Perché è molto più semplice comunicare agli sviluppatori che sei increasing è più facile stabilire un limite fin dall'inizio piuttosto che comunicare che lo stai riducendo dopo che hanno già costruito le loro app attorno ad esso.

Una volta che i tuoi limiti sono attivi, tienili d'occhio come un falco. Monitora con che frequenza gli utenti raggiungono i loro limiti e presta attenzione ai ticket di supporto. Qualcuno si sta lamentando? Utilizza quel feedback reale per modificare gradualmente le tue soglie. Questo processo iterativo garantisce che i tuoi limiti crescano e si adattino insieme alla tua base utenti, mantenendo quel cruciale equilibrio tra protezione e un'ottima esperienza per gli sviluppatori.

Comunicare i tuoi limiti agli sviluppatori

Un limite di utilizzo ben progettato è solo metà della battaglia. Se gli sviluppatori non sono informati sulle regole, la tua API non sembrerà protettiva, ma semplicemente difettosa. È qui che una comunicazione chiara diventa la tua caratteristica più importante, trasformando un potenziale punto di attrito in un'ottima esperienza per gli sviluppatori che costruisce fiducia.

Pensala in questo modo: utilizzare un'API con limiti di utilizzo nascosti è come guidare un'auto senza tachimetro o indicatore di carburante. Non hai idea di quando potresti trovarti in difficoltà. La migliore migliori pratiche per il limite di frequenza delle API Rendi i tuoi limiti trasparenti e prevedibili, fornendo agli sviluppatori gli strumenti necessari per creare applicazioni resilienti basate sul tuo servizio.

Utilizza gli header di risposta HTTP standard

Il modo più chiaro e comune per comunicare i tuoi limiti è attraverso gli header di risposta HTTP standard. Questi vengono inviati con ogni singola chiamata API riuscita, offrendo agli sviluppatori una visibilità in tempo reale sul loro utilizzo.

Questi header fungono essenzialmente da dashboard in tempo reale. Permettono agli sviluppatori di monitorare programmaticamente il loro stato e di adattare il comportamento della loro applicazione in modo fluido. Ci sono tre header che devi assolutamente includere:

X-RateLimit-LimitIl numero totale di richieste che un cliente può effettuare nell'attuale finestra temporale.X-RateLimit-RimanenteIl numero di richieste rimaste al cliente in quella finestra.X-RateLimit-ResetIl momento in cui la finestra del limite di frequenza si resetterà, solitamente fornito come timestamp Unix.

Includendo questi strumenti, offri ai sviluppatori tutto ciò di cui hanno bisogno per evitare di raggiungere il loro limite fin dall'inizio. Niente più congetture.

Gestisci con Eleganza i Limiti Superati

Prima o poi, qualcuno supererà il proprio limite. È inevitabile. La differenza tra una buona API e una frustrante sta nel modo in cui gestisci quel momento. Restituire semplicemente un messaggio di errore generico è una strada senza uscita.

Lo standard d'oro è rispondere con un 429 Richieste Troppo Frequenti Codice di stato HTTP.

Ma non fermarti qui. A 429 Potresti fornirmi il contenuto che desideri tradurre in italiano? always Potresti fornire ulteriori dettagli o il testo completo che desideri tradurre? Riprova dopo Intestazione. Questa intestazione informa il cliente esattamente quanto tempo deve attendere prima di riprovare, sia in secondi che come un timestamp specifico.

Fornire un

Riprova dopoL'intestazione trasforma un errore frustrante in un'istruzione concreta. Permette agli sviluppatori di costruire logiche di backoff intelligente e di ripetizione, trasformando un arresto definitivo in una pausa temporanea e gestibile. Questo semplice passaggio è fondamentale per creare un ecosistema API collaborativo.

Ecco cosa può fare un utile 429 come appare la risposta in pratica:

HTTP/1.1 429 Richieste Troppo Frequenti Content-Type: application/json Retry-After: 60

{ "errore": "Limite di richieste superato. Riprova tra 60 secondi." }

Questa risposta è perfetta. È chiara, concreta e aiuta gli sviluppatori a creare applicazioni robuste che si integrano perfettamente con il tuo sistema. In definitiva, una comunicazione trasparente non è solo una cortesia; è una caratteristica fondamentale di qualsiasi API ben progettata.

Strategie Avanzate di Limitazione delle Richieste

Il rate limiting di base è sufficiente per iniziare, ma una volta che ti trovi in un ambiente di produzione, scoprirai rapidamente che è solo un punto di partenza. È qui che si passa oltre a semplici regole statiche. Le strategie avanzate trasformano il rate limiting da uno strumento rozzo a un tool intelligente e flessibile che migliora attivamente le tue prestazioni, rafforza la sicurezza e ottimizza l'esperienza utente. Si tratta di costruire un sistema in grado di adattarsi in tempo reale.

Uno dei più potenti migliori pratiche per il limite di frequenza delle API is limitazione dinamica della velocità. Invece di un numero fisso, i tuoi limiti si adattano automaticamente in base alla salute del server in tempo reale. Immagina questo: l'utilizzo della CPU del tuo server aumenta improvvisamente. 80%Un sistema dinamico può immediatamente stringere i limiti di utilizzo in modo uniforme, alleggerendo il carico per prevenire un'interruzione totale del servizio. Si tratta di una difesa proattiva che mantiene la stabilità prima che gli utenti si accorgano di un problema.

Personalizza i limiti per endpoint specifici

Trattare tutti i tuoi endpoint API allo stesso modo è un errore da principianti, e anche costoso. Una semplice richiesta in sola lettura per recuperare i post del blog è completamente diversa da un colpo al tuo /accesso endpoint, che consuma più risorse ed è un bersaglio per attacchi di forza bruta.

Applicare limiti granulari basati sulle risorse è l'unico modo per costruire un sistema veramente solido. È necessario impostare soglie diverse per i vari tipi di lavoro:

- Endpoint ad alto costo: Qualsiasi endpoint che gestisce operazioni sensibili o intensive—come

/accesso,/registrati, o caricamenti di file—richiede limiti rigorosi. Questa è la tua prima linea di difesa contro gli abusi. - Endpoint in sola lettura: Per gli endpoint che forniscono semplicemente dati, come

/articolior/ prodottipuoi essere molto più generoso. Di solito sono economici da gestire. - Scrivere Operazioni: Le azioni che creano o aggiornano dati dovrebbero avere limiti moderati. È importante consentire attività legittime senza sovraccaricare il tuo database.

Questo approccio personalizzato garantisce che i tuoi punti più critici siano ben protetti senza limitare accidentalmente il traffico innocuo. È una strategia fondamentale che troverai in quasi tutti i sistemi ad alto traffico, incluso il complesso mondo di API per i social media.

Offri Limiti Variabili e Quote Personalizzate

Per qualsiasi API che serve clienti aziendali, un limite di utilizzo rigido e standardizzato può rappresentare un ostacolo insormontabile. La realtà è che il traffico non è sempre prevedibile. Una strategia intelligente consiste nell'offrire limiti variabili, che consentono a un utente di superare temporaneamente il proprio limite standard per gestire un'improvvisa impennata. Possono "prendere in prestito" da un bacino più ampio di richieste, offrendo la flessibilità necessaria per picchi a breve termine.

Offrendo quote flessibili, trasformi una potenziale limitazione in un vantaggio strategico. Questo ti consente di soddisfare le esigenze di clienti di alto valore, monetizzare la tua API in modo più efficace e offrire un'esperienza per gli sviluppatori superiore, in grado di adattarsi alle esigenze del mondo reale.

Inoltre, offrire quote personalizzate come parte dei piani premium o enterprise ti consente di adattare i livelli di servizio alle esigenze specifiche dei clienti. Questo è particolarmente vero per le aziende che stanno implementando gateway LLM, dove un controllo dettagliato sul traffico e sui costi è fondamentale. Queste strategie avanzate ti permettono di costruire un ecosistema API resiliente, equo e commercialmente di successo.

Errori comuni da evitare nella gestione dei limiti di frequenza

Implementare il rate limiting è un passo fondamentale per costruire un'API stabile e affidabile. Tuttavia, anche con le migliori intenzioni, alcuni errori comuni possono compromettere completamente il tuo lavoro e far disperare gli sviluppatori.

Imparare dagli errori altrui è uno dei modi più rapidi per costruire un sistema davvero resiliente.

L'errore più comune che riscontro è la configurazione. limiti irrealisticamente bassiQuando i tuoi limiti sono troppo restrittivi, non solo bloccano gli attori malevoli, ma danneggiano anche le app legittime. Questo porta a un'inondazione di richieste di supporto e a un'esperienza per gli sviluppatori davvero negativa. Devi iniziare analizzando il traffico reale degli utenti prima di pensare a un numero.

Un altro errore classico è un mancanza di comunicazioneSe un sviluppatore raggiunge un limite e la tua API lo ignora completamente—senza alcun avviso standard. X-RateLimit Intestazioni, no 429 errore con un aiuto Riprovare dopo istruzione—lasciali nel buio. Dal loro punto di vista, la tua API non è protetta; è semplicemente non funzionante.

Scegliere l'Approccio Sbagliato

Una strategia "taglia unica" è un'altra ricetta per il disastro. Applicare lo stesso limite generale a ogni singolo endpoint è sia superficiale che rischioso. Un endpoint ad alto traffico e a basso costo come /posta ha bisogno di un limite molto diverso rispetto a uno che richiede molte risorse come /accesso, che è un obiettivo principale per gli attacchi di forza bruta.

Finalmente, molte squadre dimenticano di fornire ai propri utenti un percorso chiaro da seguire. Cosa succede quando l'applicazione di uno sviluppatore decolla e ha bisogno di limiti più elevati per crescere?

Senza un processo documentato che consenta agli utenti di richiedere quote maggiori, crei un vicolo cieco per i tuoi clienti più di successo. Questa frizione può spingerli a cercare alternative più flessibili, ostacolando la crescita della tua piattaforma.

Evitare questi errori non riguarda solo la protezione del tuo sistema; si tratta anche di sostenere la comunità di sviluppatori che ci lavora. Gli stessi principi di comunicazione chiara e accesso a livelli sono fondamentali anche in altri ambiti. Puoi vedere come si applicano nella nostra guida su migliori pratiche per la pubblicazione sui social media.

Hai domande sul limite di frequenza?

Anche quando hai padroneggiato le basi, durante l'implementazione sorgono sempre alcune domande pratiche. Affrontiamo alcune delle più comuni che sviluppatori e architetti si trovano ad affrontare quando impostano i limiti di utilizzo nel mondo reale.

Dovrei applicare limiti di frequenza alle API interne?

Sì, dovresti assolutamente farlo. È facile considerare le API interne come una "zona di fiducia", ma sono soggette agli stessi bug e loop infiniti accidentali di qualsiasi servizio esposto al pubblico. Un microservizio fuori controllo può facilmente sovraccaricare un altro, innescando una cascata di guasti che può mandare in tilt l'intero sistema.

Pensala in questo modo: applicare limiti di frequenza ai tuoi servizi interni è un pilastro di un'architettura resiliente. Non si tratta di una mancanza di fiducia; si tratta di garantire un comportamento corretto tra i tuoi servizi e di creare una rete di sicurezza. Questo semplice passaggio può evitare che un errore onesto di un team si trasformi in un'interruzione dell'intera piattaforma.

Incarico Chiave: Il limitamento interno della velocità non riguarda la sfiducia. È una forma di disciplina automatizzata a livello di sistema che garantisce stabilità e prevedibilità, elementi imprescindibili nei sistemi complessi e distribuiti.

Come dovrei gestire i limiti per utenti autenticati e non autenticati?

Uno dei più importanti migliori pratiche per il limite di frequenza delle API è fondamentale tracciare una linea netta tra questi due gruppi. Il tuo approccio dovrebbe essere completamente diverso per ciascuno di essi.

- Utenti anonimi (non autenticati): Questi utenti dovrebbero affrontare limiti molto più severi, solitamente monitorati tramite indirizzo IP. Questa è la tua prima linea di difesa contro bot generici, web scraper e attori malintenzionati che cercano vulnerabilità.

- Utenti Conosciuti (Autenticati): Una volta che un utente accede e puoi identificarlo tramite una chiave API o un token, puoi permetterti di essere più generoso. Sai chi è, quindi puoi offrire limiti più elevati. Questo apre anche la possibilità di creare diversi livelli in base ai piani di abbonamento (ad esempio, Gratuito vs. Enterprise), costruendo un sistema equo che premia i clienti legittimi.

Questa strategia a due livelli protegge la tua infrastruttura da picchi di traffico anonimo, garantendo al contempo ai tuoi utenti reali le risorse di cui hanno bisogno.

Come funziona il rate limiting in un sistema distribuito?

Qui le cose si fanno interessanti. Se stai gestendo più server o container, non puoi permettere che ognuno di essi tracci i limiti in modo indipendente. Un utente astuto potrebbe semplicemente inviare le proprie richieste in modo rotativo a ciascuno dei tuoi server, eludendo completamente i limiti.

La soluzione è utilizzare un luogo centralizzato per tenere traccia dei punteggi. Un archivio dati veloce e in memoria come Redis è lo standard del settore per questo. Prima che un server elabori una richiesta, effettua una chiamata fulminea a Redis per controllare e incrementare il contatore dell'utente. Questo garantisce che i tuoi limiti siano applicati in modo coerente in tutto il sistema, indipendentemente da quale server gestisca la richiesta.

Stanco di combattere con una mezza dozzina di API dei social media? LATE ti offre un'unica API unificata per programmare post su sette delle principali piattaforme, facendoti risparmiare mesi di lavoro di integrazione complesso. Inizia gratuitamente su LATE.