Quando se resume tudo, a eficácia Limitação de taxa da API trata-se de criar uma experiência justa, estável e segura para todos que utilizam o seu serviço. Gosto de compará-lo a um sistema de reservas de um restaurante popular—ele evita que a cozinha fique sobrecarregada e garante que cada cliente tenha uma boa experiência.

O que é Limitação de Taxa de API e Por Que É Importante

Imagine que a sua API é a porta de entrada digital para os dados e funcionalidades da sua aplicação. Se você deixar essa porta escancarada sem ninguém a vigiar, qualquer um pode entrar de uma vez. Isso pode ser um desenvolvedor bem-intencionado com um script descontrolado, um usuário avançado com demandas pesadas, ou até mesmo um agente malicioso tentando derrubar o seu serviço.

A limitação de taxa é o segurança daquela porta digital. Mas não se trata de afastar as pessoas de forma rude. Trata-se de gerenciar o fluxo de tráfego para proteger seus sistemas de backend, garantir estabilidade e assegurar acesso justo para todos. Ela simplesmente estabelece regras claras sobre quantas solicitações um usuário pode fazer dentro de um período específico.

Os Pilares Fundamentais da Limitação de Taxa

A limitação de taxa não é apenas uma única estratégia; é uma abordagem defensiva que sustenta vários objetivos empresariais essenciais.

- Prevenção da Degradação do Serviço: Todos já vimos isso acontecer. Um loop infinito acidental em um script ou uma integração excessivamente agressiva pode sobrecarregar seus servidores, desacelerando ou até mesmo derrubando seu serviço por all os usuários. Os limites de taxa funcionam como um disjuntor, interrompendo esse tipo de uso excessivo antes que cause danos reais.

- Aprimorando a Segurança: A segurança é uma razão importante para implementar limitação de taxa, especialmente em setores sensíveis como o financeiro. Ao monitorar métricas como requisições por segundo e quais endpoints estão sendo mais acessados, você pode começar a distinguir entre a atividade normal dos usuários e um ataque malicioso, como um DDoS (Negação de Serviço Distribuída) ou uma tentativa de login por força bruta.

- Garantindo uma Alocação Justa de Recursos: Em qualquer sistema com mais de um usuário, alguns naturalmente utilizarão mais recursos do que outros. A limitação de taxa ajuda a equilibrar as condições, garantindo que um usuário de alto volume não monopolize todos os recursos e prejudique a experiência dos demais. Isso é especialmente crítico para APIs que oferecem planos escalonados (por exemplo, Gratuito, Profissional, Empresarial).

- Gestão de Custos Operacionais: Cada chamada de API que você realiza consome recursos—ciclos de CPU, memória e largura de banda—e todos esses itens têm um custo. Ao limitar o volume de requisições, você pode prever e gerenciar melhor seus gastos com infraestrutura.

Ponto Principal: A limitação de taxa não se trata apenas de dizer "não", mas sim de garantir que sua API possa consistentemente dizer "sim" a solicitações legítimas sem desmoronar sob pressão.

Observando como diferentes APIs funcionam na prática, como um API de verificação de e-mail, destaca a importância do rate limiting para prevenir abusos e manter o serviço confiável. Compreender esse conceito corretamente é o primeiro passo para construir uma aplicação resiliente e escalável, na qual desenvolvedores e usuários possam realmente confiar.

Escolhendo o Algoritmo de Limitação de Taxa Adequado

Escolher o algoritmo de limitação de taxa certo é como escolher a ferramenta adequada para um trabalho. Uma estratégia projetada para um fluxo constante de requisições falhará sob a pressão de uma repentina enxurrada de tráfego. Você não usaria um martelo para apertar um parafuso, certo? Da mesma forma, o algoritmo que você escolher deve se alinhar aos padrões de tráfego específicos da sua API e ao tipo de experiência que deseja criar para os desenvolvedores.

Compreender a mecânica de cada algoritmo é fundamental para construir uma estratégia de limitação de taxa que realmente funcione—uma que proteja seu sistema enquanto trata todos os usuários de forma justa.

Janela Fixa e Janela Deslizante

The Janela Fixa o algoritmo é o mais simples de todos. Pense nele como um contador que reinicia a cada minuto ou hora. Se o seu limite é 100 requisições por minuto, o sistema simplesmente conta acessos por segundo 0 to 59, então volta a zero para o próximo minuto.

É fácil de configurar, mas tem uma fraqueza evidente. Um pico de solicitações no final de uma janela e no início da próxima pode ultrapassar o limite e sobrecarregar seu servidor.

The Janela Deslizante o algoritmo foi desenvolvido para resolver exatamente esse problema. Ele oferece uma forma muito mais suave e precisa de limitar as taxas, monitorando as solicitações em um intervalo de tempo em movimento contínuo. Em vez de um reinício brusco, ele analisa uma média móvel, o que evita aqueles picos de tráfego que afligem janelas fixas. Isso proporciona uma proteção melhor, mas requer um pouco mais de trabalho para ser implementado.

Token Bucket e Leaky Bucket

The Cesto de Tokens o algoritmo é provavelmente uma das opções mais populares e flexíveis disponíveis. Imagine um balde que está constantemente sendo reabastecido com tokens a um ritmo constante. Cada solicitação de API consome um token. Se o balde estiver vazio, a solicitação é rejeitada.

Este modelo é fantástico para lidar com picos de tráfego. Ele permite que os usuários consumam uma grande quantidade de tokens de uma só vez para picos temporários, desde que sua taxa média permaneça dentro do limite.

Por outro lado, o Balde Furado O algoritmo processa solicitações a uma velocidade fixa e constante—imagine um funil com um pequeno orifício na parte inferior. As solicitações são adicionadas a uma fila (o balde), e o servidor as processa uma a uma. Se a fila encher, quaisquer novas solicitações são simplesmente descartadas. Essa abordagem garante um fluxo de tráfego previsível e constante da sua API, mas não é eficaz para lidar com picos de demanda.

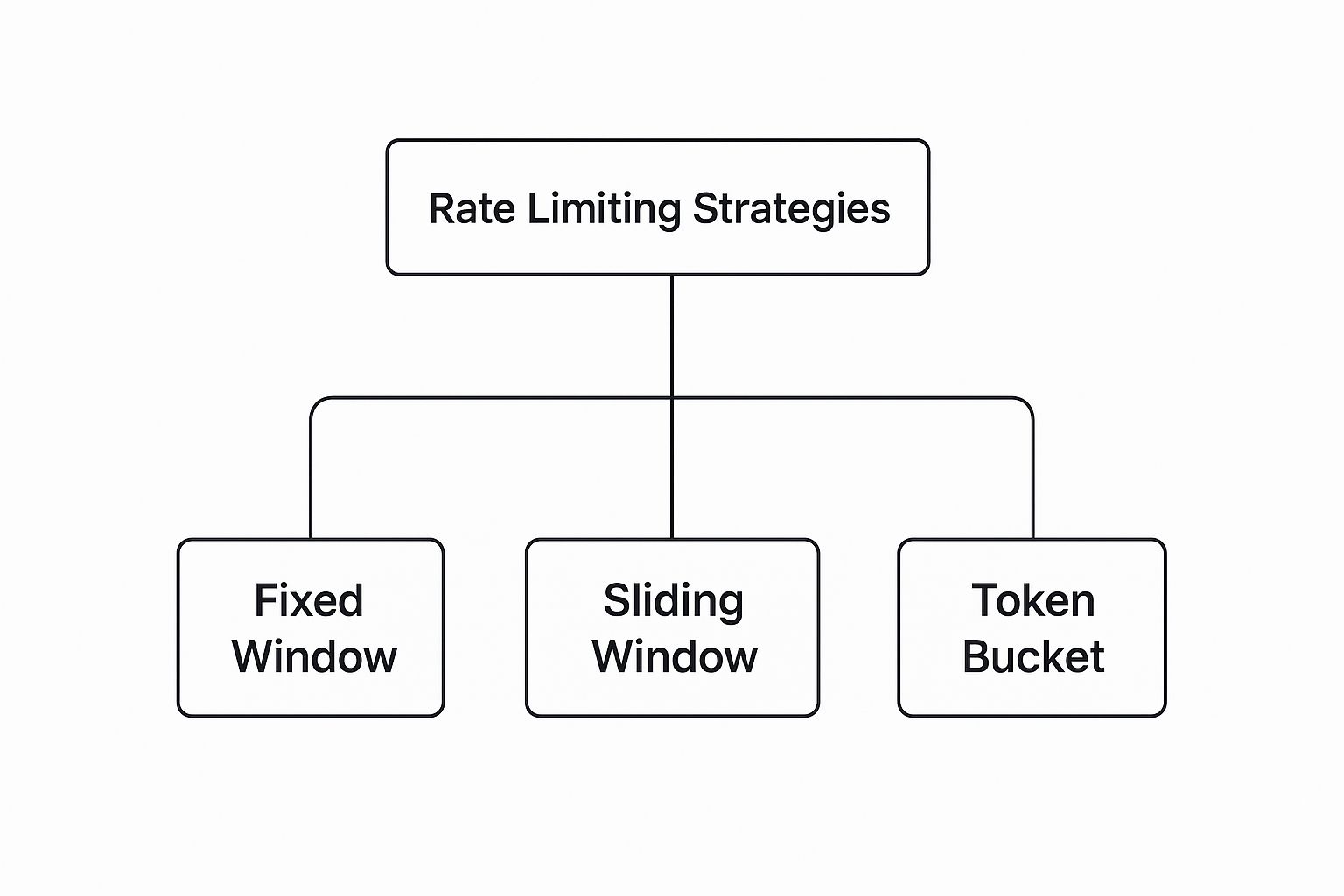

Aqui está uma visão rápida de como essas estratégias populares estão organizadas.

Como você pode ver, embora existam diferentes estratégias, opções flexíveis como o Token Bucket são frequentemente preferidas por sua capacidade de lidar com padrões de tráfego do mundo real.

Comparação de Algoritmos de Limitação de Taxa

Para tornar a escolha mais clara, é útil ver esses algoritmos lado a lado. Cada um possui suas próprias vantagens e é adequado para diferentes cenários.

| Algorithm | Melhor Para | Pros | Cons |

|---|---|---|---|

| Janela Fixa | Simplicidade e casos de uso básicos. | Fácil e barato de implementar. Baixo consumo de memória. | Pode permitir picos de tráfego nas bordas da janela. |

| Janela Deslizante | Controle de tráfego mais suave e prevenção de picos. | Limitação de taxa mais precisa. Evita problemas em casos extremos. | Maior complexidade de implementação e uso de memória. |

| Token Bucket | APIs que precisam lidar com tráfego intenso de forma justa. | Flexível, permite picos de atividade, ótima experiência do usuário. | Pode ser mais complexo ajustar a taxa de preenchimento do token. |

| Balde Furado | Sistemas que exigem um fluxo de tráfego constante e previsível. | Aprimora o fluxo de tráfego. Carga de servidor previsível. | Não suporta picos; pode resultar em solicitações perdidas. |

No final, esta tabela mostra que não existe um único algoritmo "melhor"—tudo depende do que você está tentando alcançar com sua API.

Escolher um algoritmo não é apenas uma decisão técnica; é uma decisão de produto que impacta diretamente a experiência do usuário. Um algoritmo bem escolhido transmite uma sensação de justiça e previsibilidade, enquanto uma escolha inadequada pode gerar frustração nos desenvolvedores.

Os gateways de API modernos frequentemente permitem que você configure diferentes opções, e muitos serviços agora utilizam limites dinâmicos que se ajustam com base na carga do servidor.

A melhor escolha sempre depende das suas necessidades específicas. Acertar nisso é uma parte fundamental para construir integrações sólidas e confiáveis. Você pode saber mais sobre isso lendo nosso guia sobre Melhores práticas para integração de API.

Como Definir Limites de Taxa Eficazes e Justos

Encontrar o limite de taxa adequado não é um jogo de adivinhação. Se você simplesmente escolher um número aleatório, estará se preparando para problemas. É um ato de equilíbrio estratégico. O objetivo é encontrar aquele ponto ideal onde sua infraestrutura está protegida de ser sobrecarregada, mas os desenvolvedores que utilizam sua API ainda têm uma experiência suave e previsível.

Antes de estabelecer limites para os outros, é fundamental compreender os seus próprios. Comece analisando a capacidade do seu sistema. Investigue as métricas de desempenho do seu servidor—uso da CPU, consumo de memória, carga do banco de dados—em diferentes cenários de tráfego. Isso fornece uma base clara do que o seu sistema realmente pode suportar antes que as coisas comecem a falhar.

Uma vez que você conheça seus próprios limites, concentre-se em seus usuários. Analise o comportamento deles para entender o que realmente significa um uso "normal". Quantas solicitações um usuário típico faz durante uma sessão? Quais são suas horas de pico? Uma abordagem orientada a dados como essa é a única maneira de criar limites que pareçam justos e que não bloqueiem acidentalmente usuários legítimos.

Defina o Escopo de Limitação de Taxa

Um limite único para todos é um erro clássico de novato. Nem todos os pedidos são iguais, por isso você precisa decidir how você vai acompanhar o uso e aplicar seus limites.

- Chave/API por Usuário: Esta é a forma mais comum e, francamente, a mais justa de fazê-lo. Você vincula os limites diretamente a um usuário autenticado ou à sua chave de API única. Isso garante que um usuário poderoso não possa arruinar a experiência para os demais.

- Por endereço IP: Esta é uma opção razoável para tráfego não autenticado, onde você limita as solicitações provenientes de um único IP. No entanto, tenha cuidado. Pode ficar confuso, pois vários usuários em um escritório ou em uma rede pública podem compartilhar o mesmo IP.

- Limite Global: Considere isso como sua última linha de defesa. É um limite amplo, projetado para proteger toda a sua infraestrutura de um aumento massivo e inesperado de tráfego. Trata-se menos de justiça individual e mais de pura sobrevivência.

Um dos mais importantes melhores práticas para limites de taxa de API estabelecendo limites para diferentes níveis de usuários. Muitos serviços importantes fazem isso. Por exemplo, um usuário gratuito pode receber 1.000 requisições por dia, enquanto um usuário premium pagante tem um limite muito maior de 100.000 solicitações. Esta abordagem apoia o seu modelo de negócios enquanto mantém a sua infraestrutura estável. Você pode se aprofundar em como funcionam os limites por níveis em este guia detalhado sobre Orq.ai.

Comece de forma conservadora e itere.

Quando você lançar seus limites pela primeira vez, seja cauteloso. Comece com um número mais conservador. Por quê? Porque é muito mais fácil informar aos desenvolvedores que você está increasing é mais fácil estabelecer um limite do que informar que você está reduzindo após eles já terem construído seus aplicativos em torno disso.

Assim que seus limites estiverem ativos, fique de olho neles. Acompanhe com que frequência os usuários atingem seus limites e preste atenção nos tickets de suporte. Alguém está reclamando? Utilize esse feedback do mundo real para ajustar lentamente seus limites. Esse processo iterativo garante que seus limites cresçam e se adaptem junto com sua base de usuários, mantendo o equilíbrio crucial entre proteção e uma ótima experiência para os desenvolvedores.

Comunicando Seus Limites aos Desenvolvedores

Um limite de taxa bem projetado é apenas metade da batalha. Se os desenvolvedores não tiverem clareza sobre as regras, sua API não parecerá protetora—ela apenas parecerá quebrada. É aqui que uma comunicação clara se torna seu recurso mais importante, transformando um potencial ponto de atrito em uma ótima experiência para o desenvolvedor que gera confiança.

Pense assim: usar uma API com limites de taxa ocultos é como dirigir um carro sem velocímetro ou medidor de combustível. Você não tem ideia de quando pode encontrar problemas. O melhor melhores práticas para limites de taxa da API tornando seus limites transparentes e previsíveis, fornecendo aos desenvolvedores as ferramentas necessárias para criar aplicativos resilientes sobre o seu serviço.

Utilize Cabeçalhos de Resposta HTTP Padrão

A forma mais clara e comum de comunicar seus limites é através dos cabeçalhos de resposta HTTP padrão. Estes são enviados com cada chamada de API bem-sucedida, proporcionando aos desenvolvedores visibilidade em tempo real sobre seu uso.

Esses cabeçalhos funcionam basicamente como um painel de controle ao vivo. Eles permitem que os desenvolvedores monitorem programaticamente seu status e ajustem o comportamento de suas aplicações de forma dinâmica. Existem três cabeçalhos que você precisa incluir obrigatoriamente:

X-RateLimit-LimitO número total de solicitações que um cliente pode fazer na janela de tempo atual.X-RateLimit-RemainingO número de solicitações que o cliente ainda tem disponível nesse período.X-RateLimit-ResetO momento em que a janela de limite de taxa será redefinida, quase sempre fornecido como um timestamp Unix.

Ao incluir esses elementos, você oferece aos desenvolvedores tudo o que precisam para evitar atingir seu limite desde o início. Sem suposições necessárias.

Gerencie Limites Excedidos com Elegância

Mais cedo ou mais tarde, alguém vai ultrapassar o seu limite. É inevitável. A forma como você lida com esse momento é o que diferencia uma boa API de uma frustrante. Retornar apenas uma mensagem de erro genérica é um beco sem saída.

O padrão ouro é responder com um 429 Muitas Solicitações Código de status HTTP.

Mas não pare por aí. A 429 A resposta deve always venha com um Tente Novamente Depois cabeçalho. Este cabeçalho informa ao cliente exatamente quanto tempo ele precisa esperar antes de tentar novamente, seja em segundos ou como um carimbo de data/hora específico.

Fornecendo um

Tente Novamente ApósO cabeçalho transforma um erro frustrante em uma instrução acionável. Ele permite que os desenvolvedores construam uma lógica de retrocesso inteligente e tentativas, transformando uma parada abrupta em uma pausa temporária e gerenciável. Este simples passo é fundamental para criar um ecossistema de API colaborativo.

Aqui está o que um útil 429 a resposta parece na prática:

HTTP/1.1 429 Muitas Solicitações Content-Type: application/json Retry-After: 60

{ "erro": "Limite de taxa excedido. Tente novamente em 60 segundos." }

Esta resposta é perfeita. É clara, é prática e ajuda os desenvolvedores a criar aplicações robustas que se integram bem ao seu sistema. No final, a comunicação transparente não é apenas uma cortesia; é uma característica essencial de qualquer API bem construída.

Estratégias Avançadas de Limitação de Taxa

O limite básico de taxa cumpre sua função, mas uma vez que você está em um ambiente de produção, rapidamente perceberá que é apenas o ponto de partida. É aqui que você vai além de regras simples e estáticas. Estratégias avançadas transformam o limite de taxa de um instrumento rudimentar em uma ferramenta inteligente e flexível que melhora ativamente seu desempenho, reforça a segurança e aprimora a experiência do usuário. O foco está em construir um sistema que possa se adaptar em tempo real.

Um dos mais poderosos melhores práticas para limites de taxa de API is limitação dinâmica de taxa. Em vez de um número fixo, seus limites se ajustam automaticamente com base na saúde do servidor em tempo real. Imagine isto: o uso da CPU do seu servidor dispara acima de 80%Um sistema dinâmico pode imediatamente restringir os limites de taxa em todas as áreas, aliviando a carga para evitar uma falha completa. É uma defesa proativa que mantém tudo estável antes que os usuários percebam um problema.

Ajuste os Limites para Endpoints Específicos

Tratar todos os seus endpoints de API da mesma forma é um erro de principiante, e um erro caro. Um simples pedido de leitura para buscar posts de blog é completamente diferente de uma solicitação para sua /login endpoint, que consome mais recursos e é um ímã para ataques de força bruta.

Aplicar limites granulares baseados em recursos é a única maneira de construir um sistema verdadeiramente robusto. É necessário estabelecer diferentes limites para diferentes tipos de trabalho:

- Pontos de Extremidade de Alto Custo: Qualquer endpoint que gerencie operações sensíveis ou intensivas—como

/login,/registrarou uploads de arquivos—precisam de limites rigorosos. Esta é sua primeira linha de defesa contra abusos. - Endpoints Somente para Leitura: Para endpoints que apenas fornecem dados, como

/ artigosor/ produtosvocê pode ser muito mais generoso. Normalmente, são baratos de oferecer. - Escrever Operações: As ações que criam ou atualizam dados devem ter limites moderados. É importante permitir atividades legítimas sem sobrecarregar seu banco de dados.

Essa abordagem personalizada garante que seus pontos mais críticos estejam bem protegidos, sem restringir acidentalmente o tráfego inofensivo. É uma estratégia fundamental que você encontrará em quase todos os sistemas de alto tráfego, incluindo o complexo mundo do API de redes sociais.

Ofereça Limites Variáveis e Quotas Personalizadas

Para qualquer API que atende clientes empresariais, um limite de taxa rígido e padronizado pode ser um fator decisivo. A realidade é que o tráfego nem sempre é previsível. Uma estratégia inteligente é oferecer limites expansíveis, que permitem ao usuário exceder temporariamente sua taxa padrão para lidar com um aumento repentino. Eles podem "pegar emprestado" de um maior volume de solicitações, proporcionando a flexibilidade necessária para picos de curto prazo.

Ao oferecer quotas flexíveis, você transforma uma limitação potencial em uma vantagem estratégica. Isso permite atender a clientes de alto valor, monetizar sua API de forma mais eficaz e proporcionar uma experiência superior para os desenvolvedores que se adapta às demandas do mundo real.

Além disso, oferecer cotas personalizadas como parte dos planos premium ou empresariais permite que você alinhe seus níveis de serviço às necessidades específicas dos clientes. Isso é especialmente relevante para empresas que estão implementando gateways LLM, onde o controle detalhado sobre o tráfego e os custos é fundamental. Essas estratégias avançadas capacitam você a construir um ecossistema de API resiliente, justo e comercialmente bem-sucedido.

Erros Comuns de Limitação de Taxa a Evitar

Implementar limites de taxa é um grande passo para construir uma API estável e confiável. Mas mesmo com as melhores intenções, alguns erros comuns podem comprometer todo o seu trabalho e deixar os desenvolvedores desesperados.

Aprender com os erros cometidos por outros é uma das maneiras mais rápidas de construir um sistema verdadeiramente resiliente.

O erro mais frequente que vejo é a configuração limites irrealisticamente baixosQuando seus limites são muito restritivos, não apenas impedem ações maliciosas — eles prejudicam aplicativos legítimos. Isso resulta em um aumento no número de chamados de suporte e em uma experiência de desenvolvedor ruim. É preciso começar analisando o tráfego real dos usuários antes mesmo de pensar em definir um número.

Outro erro clássico é a falha na comunicação. Se um desenvolvedor atinge um limite e sua API simplesmente o ignora—sem padrões X-RateLimit cabeçalhos, não 429 erro com uma ajuda Tente Novamente Após instrução—eles ficam no escuro. Do ponto de vista deles, sua API não está sendo protegida; ela simplesmente está quebrada.

Escolhendo a Abordagem Errada

Uma estratégia única para todos é outra receita para o desastre. Aplicar o mesmo limite geral a cada ponto de extremidade é tanto preguiçoso quanto perigoso. Um ponto de extremidade de alto tráfego e baixo custo como /postas precisa de um limite muito diferente de um que consome muitos recursos como /login, que é um alvo principal para ataques de força bruta.

Finalmente, muitas equipes esquecem de oferecer aos seus usuários um caminho claro a seguir. O que acontece quando a aplicação de um desenvolvedor decola e ele precisa de limites mais altos para escalar?

Sem um processo documentado para que os usuários solicitem aumentos de cotas, você cria um beco sem saída para seus clientes mais bem-sucedidos. Essa fricção pode levá-los a buscar alternativas mais flexíveis, prejudicando o crescimento da sua plataforma.

Evitar essas armadilhas vai além de proteger seu sistema; trata-se de apoiar a comunidade de desenvolvedores que constrói sobre ele. Os mesmos princípios de comunicação clara e acesso em camadas são fundamentais em outras áreas também. Você pode ver como isso se aplica em nosso guia sobre melhores práticas para publicações em redes sociais.

Tem perguntas sobre limitação de taxa?

Mesmo quando você já domina o básico, algumas questões práticas sempre surgem durante a implementação. Vamos abordar algumas das mais comuns que desenvolvedores e arquitetos enfrentam ao configurar limites de taxa no mundo real.

Devo limitar a taxa de uso das APIs internas?

Sim, você definitivamente deve. É tentador ver as APIs internas como uma "zona de confiança", mas elas estão tão sujeitas a bugs e loops infinitos acidentais quanto qualquer serviço voltado para o público. Um microserviço descontrolado pode facilmente sobrecarregar outro, desencadeando uma cascata de falhas que pode derrubar todo o seu sistema.

Pense assim: aplicar limites de taxa aos seus serviços internos é um pilar da arquitetura resiliente. Não se trata de falta de confiança; é sobre garantir um bom comportamento entre seus próprios serviços e criar uma rede de segurança. Este simples passo pode evitar que um erro honesto de uma equipe se transforme em uma interrupção em toda a plataforma.

Insight Principal: A limitação interna de taxa não se trata de desconfiança. É uma forma de disciplina automatizada a nível de sistema que garante estabilidade e previsibilidade, algo que é inegociável em sistemas complexos e distribuídos.

Como devo lidar com os limites para usuários autenticados e não autenticados?

Um dos mais importantes melhores práticas para limites de taxa de API é traçar uma linha clara entre esses dois grupos. Sua abordagem deve ser completamente diferente para cada um.

- Usuários Anônimos (Não Autenticados): Esses usuários devem enfrentar limites muito mais rigorosos, geralmente monitorados por endereço IP. Esta é sua primeira linha de defesa contra bots genéricos, raspadores da web e agentes mal-intencionados que buscam vulnerabilidades.

- Usuários Conhecidos (Autenticados): Uma vez que um usuário faz login e você pode identificá-lo com uma chave de API ou token, é possível ser mais generoso. Você sabe quem ele é, então pode oferecer limites mais altos. Isso também abre a possibilidade de criar diferentes níveis com base nos planos de assinatura (por exemplo, Gratuito vs. Empresarial), construindo um sistema justo que recompensa clientes legítimos.

Esta estratégia em duas frentes protege sua infraestrutura de picos de tráfego anônimo, ao mesmo tempo em que oferece aos seus usuários reais os recursos de que precisam.

Como Funciona a Limitação de Taxa em um Sistema Distribuído?

Aqui é onde as coisas ficam interessantes. Se você estiver gerenciando vários servidores ou contêineres, não pode permitir que cada um controle os limites de forma independente. Um usuário astuto poderia simplesmente enviar suas solicitações em estilo round-robin para cada um dos seus servidores e contornar completamente os limites.

A solução é utilizar um local centralizado para manter o controle. Um armazenamento de dados rápido e em memória, como Redis é o padrão da indústria para isso. Antes que qualquer servidor processe uma solicitação, ele faz uma chamada ultrarrápida ao Redis para verificar e incrementar o contador do usuário. Isso garante que seus limites sejam aplicados de forma consistente em todo o sistema, independentemente de qual servidor receba a solicitação.

Cansado de lutar com meia dúzia de APIs de redes sociais? LATE oferece uma API unificada para agendar publicações em sete plataformas principais, economizando meses de trabalho doloroso de integração. Comece gratuitamente no LATE.