Cuando se reduce todo a lo esencial, la efectividadLimitación de tasa de APIse trata de crear una experiencia justa, estable y segura para todos los que utilizan tu servicio. Me gusta compararlo con un sistema de reservas para un restaurante popular: evita que la cocina se sature y asegura que cada cliente disfrute de su visita.

¿Qué es el límite de tasa de API y por qué es importante?

Imagina que tu API es la puerta digital de acceso a los datos y características de tu aplicación. Si dejas esa puerta completamente abierta sin vigilancia, cualquiera podría entrar de golpe. Esto podría ser un desarrollador bien intencionado con un script descontrolado, un usuario avanzado con demandas exigentes, o incluso un actor malicioso intentando llevar tu servicio al límite.

La limitación de tasa es como el portero en esa puerta digital. Pero no se trata de rechazar a la gente de manera grosera. Se trata de gestionar el flujo de tráfico para proteger tus sistemas internos, asegurar la estabilidad y garantizar un acceso equitativo para todos. Simplemente establece reglas claras sobre cuántas solicitudes puede hacer un usuario en un período específico.

Los Pilares Fundamentales de la Limitación de Tasa

La limitación de tasas no es solo un truco aislado; es una estrategia defensiva que respalda varios objetivos clave del negocio.

- Prevención de la degradación del servicio:Todos hemos sido testigos de esto. Un bucle infinito accidental en un script o una integración demasiado agresiva pueden sobrecargar tus servidores, ralentizando o incluso colapsando tu servicio.allLos límites de uso funcionan como un interruptor de circuito, deteniendo este tipo de uso descontrolado antes de que cause daños reales.

- Mejorando la Seguridad:La seguridad es una de las principales razones para implementar limitaciones de tasa, especialmente en industrias sensibles como la financiera. Al monitorear métricas como las solicitudes por segundo y qué endpoints reciben más tráfico, puedes comenzar a distinguir entre la actividad normal de los usuarios y un ataque malicioso, como un DDoS (Denegación de Servicio Distribuida) o un intento de acceso por fuerza bruta.

- Asegurando una Distribución Justa de Recursos:En cualquier sistema con más de un usuario, es natural que algunos utilicen más recursos que otros. La limitación de tasas ayuda a equilibrar la situación, asegurando que un usuario de alto volumen no acapare todos los recursos y arruine la experiencia para los demás. Esto es especialmente crucial para las API que ofrecen planes escalonados (por ejemplo, Gratuito, Pro, Empresarial).

- Gestión de Costos Operativos:Cada llamada a la API que realizas consume recursos: ciclos de CPU, memoria y ancho de banda, y todos estos elementos tienen un costo. Al establecer un límite en el volumen de solicitudes, podrás predecir y gestionar mejor tus gastos en infraestructura.

Conclusión clave:La limitación de tasa no se trata tanto de decir "no", sino de garantizar que tu API pueda decir "sí" de manera consistente a las solicitudes legítimas sin colapsar bajo presión.

Observando cómo funcionan diferentes APIs en el mundo real, como unAPI de verificación de correo electrónicosubraya la importancia de la limitación de tasas para prevenir abusos y mantener la fiabilidad del servicio. Comprender este concepto es el primer paso para construir una aplicación resiliente y escalable en la que tanto los desarrolladores como los usuarios puedan confiar plenamente.

Elegir el Algoritmo de Limitación de Tasa Adecuado

Elegir el algoritmo de limitación de tasas adecuado es como seleccionar la herramienta correcta para un trabajo. Una estrategia diseñada para un flujo constante de solicitudes se verá superada ante la presión de un repentino aumento de tráfico. No usarías un martillo para atornillar, ¿verdad? De igual manera, el algoritmo que elijas debe coincidir con los patrones de tráfico específicos de tu API y con el tipo de experiencia que deseas ofrecer a los desarrolladores.

Entender la mecánica detrás de cada algoritmo es fundamental para desarrollar una estrategia de limitación de tasas que realmente funcione: una que proteja tu sistema y, al mismo tiempo, trate a cada usuario de manera justa.

Ventana Fija y Ventana Deslizante

The Ventana Fijael algoritmo es el más sencillo de todos. Piensa en él como un contador que se reinicia cada minuto o cada hora. Si tu límite es100solicitudes por minuto, el sistema simplemente cuenta las visitas desde el segundoto 59, luego vuelve a cero para el siguiente minuto.

Es fácil de configurar, pero tiene una debilidad evidente. Un aumento repentino de solicitudes justo al final de una ventana y al comienzo de la siguiente puede colarse por el límite y sobrecargar tu servidor.

The Ventana DeslizanteEl algoritmo fue diseñado para solucionar este problema específico. Ofrece una forma mucho más fluida y precisa de limitar las tasas al rastrear las solicitudes en un marco temporal en constante movimiento. En lugar de un reinicio abrupto, se basa en un promedio móvil, lo que evita esos picos de tráfico extremos que afectan a las ventanas fijas. Esto te brinda una mejor protección, aunque requiere un poco más de esfuerzo para implementarlo.

Cubo de Tokens y Cubo con Fugas

The Cesta de TokensEl algoritmo es probablemente una de las opciones más populares y flexibles que existen. Imagina un cubo que se está llenando constantemente con tokens a un ritmo constante. Cada solicitud a la API consume un token. Si el cubo está vacío, la solicitud es rechazada.

Este modelo es ideal para gestionar picos de tráfico. Permite a los usuarios consumir una gran cantidad de tokens de una sola vez para momentos de alta demanda, siempre que su tasa promedio se mantenga dentro del límite.

Por otro lado, elCubo con FugasEl algoritmo procesa las solicitudes a una velocidad fija y constante—imagina un embudo con un pequeño agujero en la parte inferior. Las solicitudes se añaden a una cola (el cubo), y el servidor las procesa una por una. Si la cola se llena, cualquier nueva solicitud se descarta. Este enfoque garantiza un flujo de tráfico predecible y constante desde tu API, pero no es muy eficiente para manejar picos de actividad.

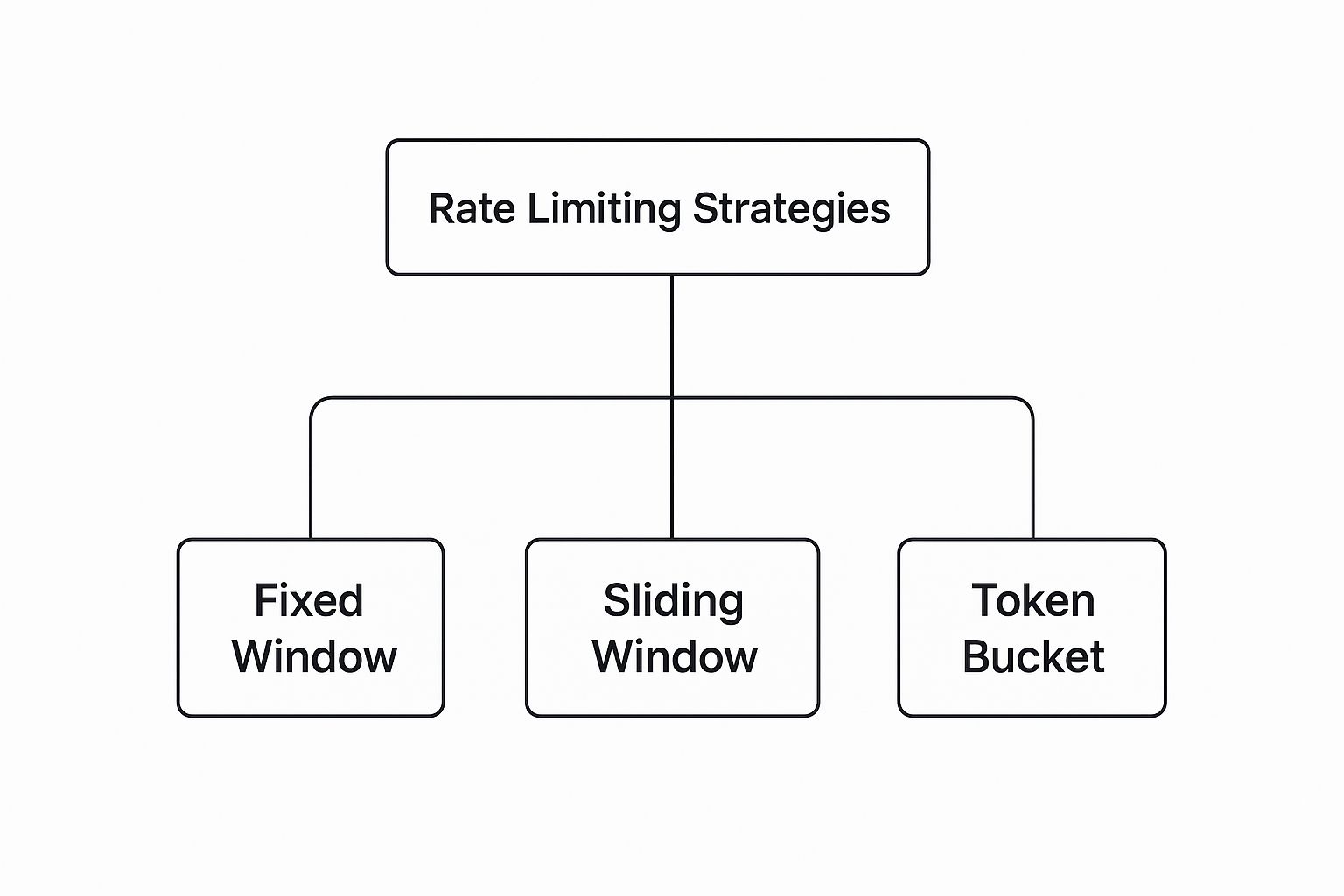

Aquí tienes una visualización rápida de cómo se organizan estas estrategias populares.

Como puedes ver, aunque existen diferentes estrategias, opciones flexibles como Token Bucket suelen ser las preferidas por su capacidad para gestionar patrones de tráfico del mundo real.

Comparativa de Algoritmos de Limitación de Tasa

Para aclarar la elección, es útil ver estos algoritmos uno al lado del otro. Cada uno tiene sus propias ventajas y es adecuado para diferentes situaciones.

| Algorithm | Mejor para | Pros | Cons |

|---|---|---|---|

| Ventana Fija | Simplicidad y casos de uso básicos. | Fácil y económico de implementar. Bajo consumo de memoria. | Puede permitir picos de tráfico en los bordes de la ventana. |

| Ventana Deslizante | Control de tráfico más fluido y prevención de picos. | Limitación de tasa más precisa. Evita problemas en casos extremos. | Mayor complejidad en la implementación y uso de memoria. |

| Cubo de Tokens | APIs que deben gestionar tráfico variable de manera equitativa. | Flexible, permite publicaciones rápidas y ofrece una excelente experiencia de usuario. | Puede ser más complicado ajustar la tasa de llenado de tokens. |

| Cubo con Fugas | Sistemas que requieren un flujo constante y predecible de tráfico. | Optimiza el flujo de tráfico. Carga del servidor predecible. | No admite picos; puede provocar la pérdida de solicitudes. |

En última instancia, esta tabla muestra que no hay un único "mejor" algoritmo; todo depende de lo que quieras lograr con tu API.

Elegir un algoritmo no es solo una decisión técnica; es una decisión de producto que impacta directamente en la experiencia del usuario. Un algoritmo bien seleccionado se percibe como justo y predecible, mientras que una mala elección puede generar frustración en los desarrolladores.

Los modernos gateways de API a menudo te permiten configurar diferentes opciones, y muchos servicios incluso están utilizando límites dinámicos que se ajustan según la carga del servidor.

La mejor opción siempre depende de tus necesidades específicas. Acertar en esto es fundamental para construir integraciones sólidas y confiables. Puedes aprender más sobre esto leyendo nuestra guía sobreMejores prácticas para la integración de API.

Cómo Establecer Límites de Tasa Efectivos y Justos

Determinar el límite de tasa adecuado no es un juego de adivinanzas. Si simplemente eliges un número al azar, te estarás preparando para enfrentar problemas. Es un acto de equilibrio estratégico. El objetivo es encontrar ese punto ideal donde tu infraestructura esté protegida de sobrecargas, pero los desarrolladores que utilizan tu API sigan teniendo una experiencia fluida y predecible.

Antes de establecer límites en los demás, es fundamental que comprendas los tuyos. Comienza por analizar la capacidad de tu sistema. Profundiza en las métricas de rendimiento de tu servidor: uso de CPU, consumo de memoria, carga de la base de datos, en diferentes escenarios de tráfico. Esto te proporcionará una base clara de lo que tu sistema realmente puede manejar antes de que las cosas empiecen a fallar.

Una vez que conozcas tus propios puntos de quiebre, dirige tu atención hacia tus usuarios. Analiza su comportamiento para entender lo que realmente significa un uso "normal". ¿Cuántas solicitudes realiza un usuario típico durante una sesión? ¿Cuáles son tus horas pico? Un enfoque basado en datos como este es la única manera de establecer límites que se sientan justos y que no bloqueen accidentalmente a usuarios legítimos.

Define el Alcance de tu Limitación de Tasa

Un límite único para todos es un error clásico de principiante. No todas las solicitudes son iguales, así que debes decidirhowVas a monitorear el uso y aplicar tus límites.

- Clave/API por usuario:Esta es la forma más común y, sinceramente, la más justa de hacerlo. Asocias los límites directamente a un usuario autenticado o a su clave API única. Esto garantiza que un usuario avanzado no arruine la experiencia para los demás.

- Por dirección IP:Esta es una opción adecuada para el tráfico no autenticado, donde limitas las solicitudes que provienen de una sola IP. Sin embargo, ten cuidado. Puede volverse complicado, ya que varios usuarios en una oficina o en una red pública pueden compartir la misma IP.

- Límite Global:Considera esto como tu última línea de defensa. Es un límite amplio, diseñado para proteger toda tu infraestructura de un aumento masivo e inesperado de tráfico. Se trata menos de equidad individual y más de pura supervivencia.

Uno de los más importantesmejores prácticas para el límite de tasa de APIestá adaptando los límites a diferentes niveles de usuarios. Muchos servicios importantes hacen esto. Por ejemplo, un usuario gratuito podría recibir1,000solicitudes por día, mientras que un usuario premium paga recibe un límite mucho más alto de100,000solicitudes. Este enfoque respalda tu modelo de negocio mientras mantiene tu infraestructura estable. Puedes profundizar en cómo funcionan los límites por niveles enesta guía detallada sobre Orq.ai.

Comienza de manera conservadora y ve ajustando.

Cuando lances tus límites por primera vez, es mejor ser cauteloso. Comienza con un número más conservador. ¿Por qué? Porque es mucho más fácil comunicar a los desarrolladores que estásincreasinges más fácil establecer un límite desde el principio que informarles que lo estás reduciendo después de que ya han construido sus aplicaciones en torno a ello.

Una vez que tus límites estén activos, obsérvalos de cerca. Monitorea con qué frecuencia los usuarios alcanzan sus máximos y presta atención a los tickets de soporte. ¿Hay alguien que se queje? Utiliza esa retroalimentación del mundo real para ajustar lentamente tus umbrales. Este proceso iterativo garantiza que tus límites crezcan y se adapten junto con tu base de usuarios, manteniendo ese equilibrio crucial entre protección y una excelente experiencia para los desarrolladores.

Comunica tus límites a los desarrolladores

Un límite de tasa bien diseñado es solo la mitad de la batalla. Si los desarrolladores no tienen claridad sobre las reglas, tu API no se sentirá protectora; simplemente parecerá estar rota. Aquí es donde una comunicación clara se convierte en tu característica más importante, transformando un posible punto de fricción en una excelente experiencia para los desarrolladores que genera confianza.

Piénsalo así: usar una API con límites de tasa ocultos es como conducir un coche sin velocímetro ni medidor de combustible. No tienes idea de cuándo podrías tener problemas. Lo mejormejores prácticas para el límite de tasa de APIhaz que tus límites sean transparentes y predecibles, proporcionando a los desarrolladores las herramientas necesarias para crear aplicaciones resilientes sobre tu servicio.

Utiliza encabezados de respuesta HTTP estándar

La forma más clara y común de comunicar tus límites es a través de los encabezados de respuesta HTTP estándar. Estos se envían con cada llamada exitosa a la API, brindando a los desarrolladores visibilidad en tiempo real sobre su uso.

Estos encabezados funcionan como un panel de control en tiempo real. Permiten a los desarrolladores rastrear su estado de manera programática y ajustar el comportamiento de su aplicación de forma ágil. Hay tres encabezados que debes incluir sin falta:

Límite de X-RateLimitEl número total de solicitudes que un cliente puede realizar en la ventana de tiempo actual.X-LímiteDeTasa-RemainingEl número de solicitudes que le quedan al cliente en esa ventana.X-RateLimit-ResetEl momento en que se reiniciará la ventana de límite de tasa, casi siempre indicado como una marca de tiempo Unix.

Al incluir estos elementos, les proporcionas a los desarrolladores todo lo que necesitan para evitar alcanzar su límite desde el principio. Sin conjeturas necesarias.

Gestiona con elegancia los límites superados.

Tarde o temprano, alguien superará su límite. Es inevitable. La forma en que manejes ese momento es lo que distingue una buena API de una frustrante. Simplemente devolver un mensaje de error genérico es un callejón sin salida.

El estándar de oro es responder con un429 Demasiadas SolicitudesCódigo de estado HTTP.

Pero no te detengas ahí. Un429Por favor, proporciona el contenido que deseas que traduzca.alwaysviene con unReintentar despuésEncabezado. Este encabezado informa al cliente exactamente cuánto tiempo debe esperar antes de intentar nuevamente, ya sea en segundos o como una marca de tiempo específica.

Reintentar despuésEl encabezado transforma un error frustrante en una instrucción clara. Permite a los desarrolladores implementar lógica de retroceso inteligente y reintentos, convirtiendo una detención abrupta en una pausa temporal y manejable. Este simple paso es fundamental para crear un ecosistema de API colaborativo.

Aquí tienes lo que un buen429cómo se ve la respuesta en la práctica:

HTTP/1.1 429 Demasiadas Solicitudes Content-Type: application/json Retry-After: 60

{ "error": "Límite de tasa excedido. Por favor, inténtalo de nuevo en 60 segundos." }

Esta respuesta es perfecta. Es clara, es práctica y ayuda a los desarrolladores a crear aplicaciones sólidas que se integren sin problemas con tu sistema. Al final, la comunicación transparente no es solo una cortesía; es una característica fundamental de cualquier API bien diseñada.

Estrategias Avanzadas de Limitación de Tasa

El límite de tasa básico cumple su función, pero una vez que estás en un entorno de producción, rápidamente te darás cuenta de que es solo el punto de partida. Aquí es donde pasas más allá de reglas simples y estáticas. Las estrategias avanzadas transforman el límite de tasa de un instrumento tosco en una herramienta inteligente y flexible que potencia tu rendimiento, refuerza la seguridad y mejora la experiencia del usuario. Se trata de construir un sistema que pueda adaptarse sobre la marcha.

Uno de los más poderososmejores prácticas para el límite de tasa de API is limitación dinámica de tasas. En lugar de un número fijo, tus límites se ajustan automáticamente según la salud del servidor en tiempo real. Imagina esto: el uso de CPU de tu servidor se dispara durante80%Un sistema dinámico puede ajustar de inmediato los límites de tasa en todos los frentes, aliviando la carga para prevenir una caída total. Es una defensa proactiva que mantiene la estabilidad antes de que los usuarios se den cuenta de un problema.

Personaliza los límites para endpoints específicos

Tratar todos tus endpoints de API de la misma manera es un error de principiante, y uno costoso. Una simple solicitud de solo lectura para obtener publicaciones de blog es completamente diferente a un acceso a tu/iniciar-sesionendpoint, que consume más recursos y es un imán para ataques de fuerza bruta.

Aplicar límites granulares basados en recursos es la única forma de construir un sistema realmente sólido. Es necesario establecer diferentes umbrales para distintos tipos de trabajo:

- Puntos de acceso de alto costo:Cualquier endpoint que maneje operaciones sensibles o intensivas—como

/iniciar-sesion/registraro las cargas de archivos, necesitan límites estrictos. Esta es tu primera línea de defensa contra el abuso. - Puntos de acceso de solo lectura:Para los endpoints que solo proporcionan datos, como

/artículosor/productospuedes ser mucho más generoso. Por lo general, son económicos de ofrecer. - Operaciones de Escritura:Las acciones que crean o actualizan datos deben tener límites moderados. Quieres permitir actividades legítimas sin sobrecargar tu base de datos.

Este enfoque personalizado garantiza que tus puntos más críticos estén bien protegidos sin limitar accidentalmente el tráfico inofensivo. Es una estrategia clave que encontrarás en casi todos los sistemas de alto tráfico, incluyendo el complejo mundo de las redes sociales.API de redes sociales.

Ofrece límites flexibles y cuotas personalizadas.

Para cualquier API que atienda a clientes empresariales, un límite de tasa rígido y uniforme puede ser un factor decisivo. La realidad es que el tráfico no siempre es predecible. Una estrategia inteligente es ofrecerlímites escalables, que permiten a un usuario superar temporalmente su tasa estándar para manejar un aumento repentino. Pueden "tomar prestado" de un mayor volumen de solicitudes, brindándoles la flexibilidad que necesitan para picos a corto plazo.

Al ofrecer cuotas flexibles, conviertes una posible limitación en una ventaja estratégica. Esto te permite atender a clientes de alto valor, monetizar tu API de manera más efectiva y proporcionar una experiencia de desarrollo superior que se adapta a las demandas del mundo real.

Además, ofrecer cuotas personalizadas como parte de los planes premium o empresariales te permite ajustar tus niveles de servicio a las necesidades específicas de cada cliente. Esto es especialmente relevante para las empresas que están implementando puertas de enlace LLM, donde el control detallado sobre el tráfico y los costos es fundamental. Estas estrategias avanzadas te permiten construir un ecosistema de API resiliente, justo y comercialmente exitoso.

Errores Comunes en la Limitación de Tasa que Debes Evitar

Implementar limitaciones de tasa es un gran paso hacia la creación de una API estable y confiable. Sin embargo, incluso con las mejores intenciones, algunos errores comunes pueden socavar por completo tu trabajo y dejar a los desarrolladores desesperados.

Aprender de los errores que otros han cometido es una de las formas más rápidas de construir un sistema que sea realmente resistente.

El error más común que veo es la configuración.límites irrealmente bajosCuando tus límites son demasiado restrictivos, no solo detienen a los actores malintencionados, sino que también perjudican a las aplicaciones legítimas. Esto genera una avalancha de tickets de soporte y una experiencia de desarrollo terrible. Debes comenzar analizando el tráfico real de los usuarios antes de siquiera pensar en establecer un número.

Otro error clásico es unfalta de comunicaciónSi un desarrollador alcanza un límite y tu API simplemente lo ignora—sin ningún estándarX-LímiteDeTasaencabezados, no429error con un mensaje útilReintentar despuésinstrucción—se quedan en la oscuridad. Desde su perspectiva, tu API no está siendo protegida; simplemente está rota.

Elegir el Enfoque Incorrecto

Una estrategia única para todos es otra receta para el desastre. Aplicar el mismo límite general a cada punto final es tanto perezoso como arriesgado. Un punto final de alto tráfico y bajo costo como/publicacionesnecesita un límite muy diferente al de uno que consume muchos recursos como/iniciar-sesion, que es un objetivo principal para ataques de fuerza bruta.

Finalmente, muchos equipos olvidan ofrecer a sus usuarios un camino claro hacia adelante. ¿Qué sucede cuando la aplicación de un desarrollador despega y necesita límites más altos para escalar?

Sin un proceso documentado que permita a los usuarios solicitar cuotas aumentadas, estás creando un callejón sin salida para tus clientes más exitosos. Esta fricción puede llevarlos a buscar alternativas más flexibles, lo que obstaculiza el crecimiento de tu plataforma.

Evitar estos errores va más allá de simplemente proteger tu sistema; se trata de apoyar a la comunidad de desarrolladores que lo utiliza. Los mismos principios de comunicación clara y acceso escalonado son fundamentales en otras áreas también. Puedes ver cómo se aplica esto en nuestra guía sobremejores prácticas para publicar en redes sociales.

¿Tienes preguntas sobre la limitación de tasas?

Incluso cuando ya dominas lo básico, siempre surgen algunas preguntas prácticas durante la implementación. Vamos a abordar algunas de las más comunes que enfrentan desarrolladores y arquitectos al establecer límites de tasa en el mundo real.

¿Debería establecer límites de tasa en las APIs internas?

Sí, definitivamente deberías hacerlo. Es tentador ver las API internas como una "zona de confianza", pero son igual de propensas a errores y bucles infinitos accidentales que cualquier servicio expuesto al público. Un microservicio descontrolado puede afectar fácilmente a otro, desencadenando una cascada de fallos que puede derribar todo tu sistema.

Piénsalo de esta manera: aplicar límites de tasa a tus servicios internos es fundamental para una arquitectura resiliente. No se trata de una falta de confianza; se trata de fomentar un buen comportamiento entre tus propios servicios y crear una red de seguridad. Este simple paso puede evitar que un error honesto de un equipo se convierta en una caída general de la plataforma.

Perspectiva Clave:La limitación interna de la tasa no se trata de desconfianza. Es una forma de disciplina automatizada a nivel de sistema que garantiza estabilidad y previsibilidad, lo cual es innegociable en sistemas complejos y distribuidos.

¿Cómo debo gestionar los límites para usuarios autenticados y no autenticados?

Uno de los aspectos más importantesmejores prácticas para el límite de tasa de APIes trazar una línea clara entre estos dos grupos. Tu enfoque debe ser completamente diferente para cada uno.

- Usuarios anónimos (no autenticados):Estos usuarios deben enfrentarse a límites mucho más estrictos, que normalmente se rastrean por dirección IP. Esta es tu primera línea de defensa contra bots genéricos, raspadores web y actores malintencionados que buscan vulnerabilidades.

- Usuarios Conocidos (Autenticados):Una vez que un usuario inicia sesión y puedes identificarlo con una clave API o un token, puedes permitirte ser más generoso. Sabes quién es, así que puedes ofrecer límites más altos. Esto también abre la puerta a la creación de diferentes niveles basados en los planes de suscripción (por ejemplo, Gratis vs. Empresarial), construyendo un sistema justo que recompense a los clientes legítimos.

Esta estrategia de dos frentes protege tu infraestructura de picos de tráfico anónimo, al mismo tiempo que proporciona a tus usuarios reales los recursos que necesitan.

¿Cómo funciona la limitación de tasa en un sistema distribuido?

Aquí es donde las cosas se ponen interesantes. Si estás gestionando múltiples servidores o contenedores, no puedes permitir que cada uno controle los límites por su cuenta. Un usuario astuto podría simplemente enviar sus solicitudes de manera rotativa a cada uno de tus servidores y eludir completamente los límites.

La solución es utilizar un lugar centralizado para llevar el control. Un almacén de datos rápido en memoria comoRedises el estándar de la industria para esto. Antes de que cualquier servidor procese una solicitud, realiza una llamada ultrarrápida a Redis para verificar e incrementar el contador del usuario. Esto garantiza que tus límites se apliquen de manera consistente en todo el sistema, sin importar qué servidor reciba la solicitud.

¿Cansado de lidiar con media docena de APIs de redes sociales?LATEte ofrece una API unificada para programar publicaciones en siete plataformas principales, ahorrándote meses de trabajo de integración complicado.Empieza gratis en LATE..